Элементарный перцептрон Ф. Розенблатта

В 1957 году американским нейрофизиологом Ф. Розенблаттом была предложена одна из первых моделей ИНС, названная иерцептроном [2]. Ее отличительная черта - способность обучаться распознаванию простых зрительных образов. Вскоре перцептрон был реализован в виде модели НС Mark 1. С тех пор началось активное развитие нейрокомпьютеров.

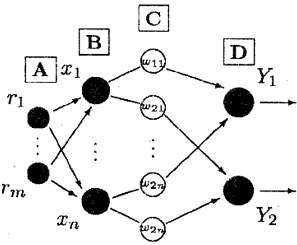

А - слой С-элементов

В - слой А-элементов

С - слой настраиваемых весов

D - слой Р-элементов

Рис. 3.5. Архитектура перцептрона Ф. Розенблатта

Перцептрон (рис. 3.5) состоит из детерминированных пороговых НЭ трех типов:

сенсорные НЭ (С-элементы) r1,..., rn ("сетчатка"), которые воспринимают входные образы;

ассоциативные НЭ (А-элементы) x1,..., хn, связанные с сенсорными НЭ, выполняют роль детекторов признаков;

решающие НЭ (Р-элементы), связанные настраиваемыми связями с ассоциативными НЭ, служат для принятия решений.

Обычно число Р-элементов выбирают равным количеству классов, на которое необходимо разбить предъявляемые перцептрону образы.

Рассмотренная модель ИНС относится к классу сетей с прямыми связями (feedforward), один из слоев которых является модифицируемым.

В простейшем случае, когда n=m и хi = ri, i = 1...n, детекторы признаков могут рассматриваться как входной слой. Тогда перцептрон вырождается в один пороговый НЭ с т входами, называемый элементарным перцептроном.

Перцептрон реагирует на входной образ (вектор) генерацией сигнала на выходе Р-элемента. Он функционирует в двух режимах:

в режиме обучения перцептрона в пространстве признаков x1, ..., хm формируется гиперплоскость, которая делит это пространство на два класса;

в режиме распознавания перцептрон определяет, к какому из классов относится входной образ. Так производится бинарная классификация входных образов.

Решение перцептроном конкретной задачи распознавания обеспечивается с помощью настройки весов связей в режиме обучения.

Основными недостатками элементарного перцептрона являются:

ограниченность круга задач, решаемых этой ИНС (из-за линейности разделяющей классы поверхности);

большая длительность процесса обучения (из-за необходимости многократного предъявления всей обучающей выборки).

Многослойный перцептрон

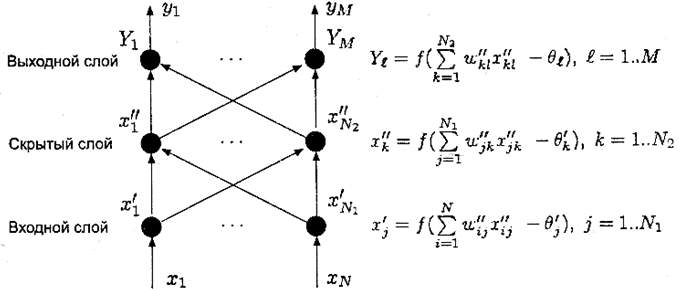

Многослойный перцептрон - это ИНС с прямыми связями (feedforward), в которой имеется несколько слоев НЭ с настраиваемыми весами связей. Рис. З.б. Архитектура трехслойного перцептрона

Архитектура трехслойного перцептрона, получившего наибольшее распространение, приведена на рис. 3.6.

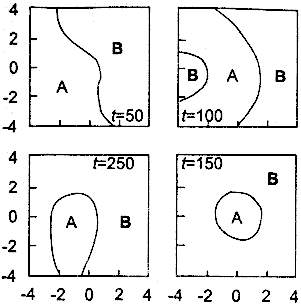

Входные сигналы, соответствующие классам А и В, попеременно подавались на вход перцептона. Элементы класса А равномерно распределены внутри окружности, а элементы класса В расположены вне ее

Рис. 3.7. Пример области, описываемой трехслойным перцептроном

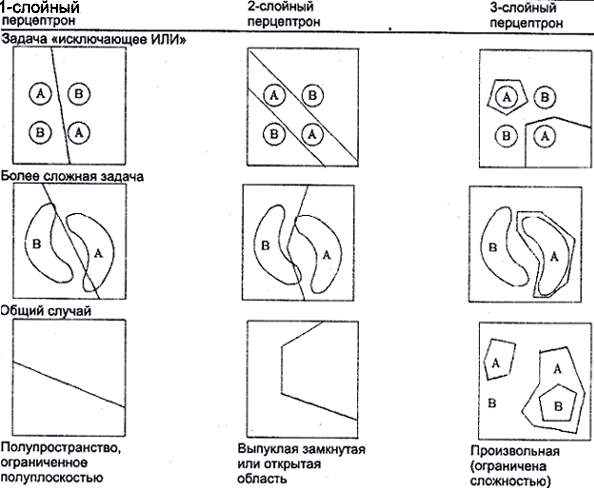

Рис. 3.8. Вид областей решений для перцептронов

В отличие от элементарного перцептрона, формирующего классифицирующую гиперплоскость, многослойный перцептрон может формировать в режиме обучения сложные нелинейные гиперповерхности (кусочно-линейные, полиномиальные и т. п.) (рис. 3.7). Благодаря этому многослойный перцептрон способен распознавать произвольное число классов, имеющих сложную структуру в пространстве первичных признаков. При этом классы могут представлять собой выпуклые, невыпуклые и многосвязные объекты (рис. 3.8).

Таким образом, многослойный перцептрон с достаточным количеством внутренних НЭ и соответствующей матрицей связей принципиально способен осуществлять любое преобразование <вход-выход>, аппроксимировать любую решающую (распознающую) функцию с любой наперед заданной точностью. Для этого необходимо:

- выбрать архитектуру перцептрона, а именно: число слоев, число НЭ и их тип;

- настроить веса связей НЭ с помощью некоторого алгоритма обучения.

Нейросети Хопфилда

Сети Хопфилда представляют собой широкий класс ИНС, включающий в себя многие типы ИНС в качестве частных подклассов. Это обусловлено тем, что сеть Хопфилда является абсолютно однородной структурой без какой-либо внутренней специализации ее НЭ.

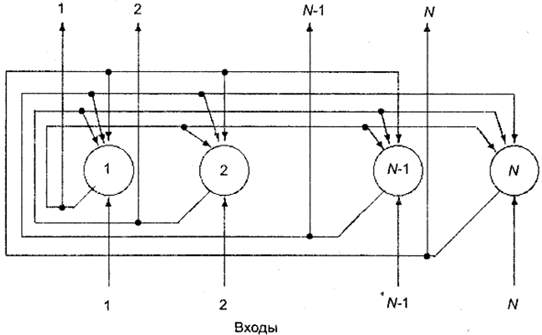

Рис. 3.9. Архитектура ИНС Хопфилда

Выход каждого из НЭ сети связан настраиваемыми связями с входами всех других НЭ. Отсутствуют только связи собственного выхода с собственным входом (рис. 3.9).

Сеть Хопфилда предназначена для запоминания нескольких устойчивых выходных состояний (эталонных образов) и может работать в качестве устройства ассоциативной памяти.

Для этого необходимо перед началом работы рассчитать симметричную матрицу связей НЭ сети.

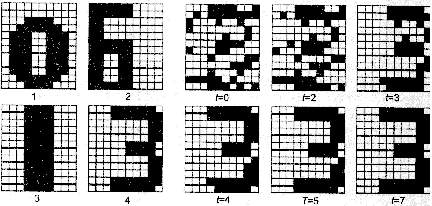

Эталонные образы

Итерация сети

В момент t=0 подан эталон 3, искаженный случайным шумом с вероятностью инвертирования каждого элемента 0,25

Рис. 3.10. Ассоциативные свойства ИНС Хопфилда

Записывая в сеть некоторый входной образ (например, частично искаженный эталон), можно сформировать правильный выходной образ (эталон без искажений) после достижения сетью стабильного состояния (рис. 3.10). Разновидности сетей Хопфилда

Существуют две основные разновидности ИНС Хопфилда:

- ИНС с пороговыми НЭ;

- ИНС с сигмоидальными НЭ.

Рис. 3.11. Механическая аналогия поведения ИНС Хопфилда

ИНС с пороговыми НЭ функционируют в асинхронном режиме, то есть каждый НЭ в случайные моменты времени с некоторой средней частотой определяет свое состояние. В качестве порогового уровня для всех НЭ обычно выбирается ноль.

Благодаря этому оказалось возможным описать динамику ИНС Хопфилда в рамках энергетического подхода. При этом оказывается полезной механическая аналогия между поведением сети и движением шарика по некоторому вязкому рельефу под действием силы тяжести (рис. 3.11).

Поведение ИНС с сигмоидными НЭ описывается системой нелинейных дифференциальных уравнений, учитывающих синхронность и непрерывность переключения НЭ.

Основными недостатками ИНС Хопфилда являются:

- неэкономное использование памяти (количество случайных образов, которое сеть может запомнить с вероятностью последующего восстановления, равной 1, не превышает 15 % от общего количества НЭ);

- чувствительность к искажениям распознаваемых образов (сеть имеет весьма скромные возможности распознавания, так как допустимо лишь искажение образов ограниченным аддитивным шумом);

- неинвариантность к геометрическим преобразованиям образов (например, к аффинным или проективным преобразованиям распознаваемых изображений).

Нейросети Хемминга

ИНС Хемминга реализует оптимальный в смысле минимума ошибки алгоритм классификации, используемый для решения задач в области связи (восстановление искаженного случайным шумом эталонного сигнала).

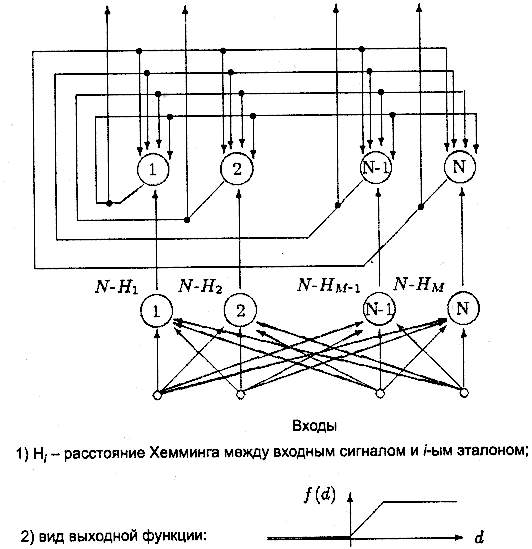

Рис. 3.12. Архитектура ИНС Хемминга

Архитектура ИНС Хемминга показана на рис. 3.12.

Сеть представляет собой двухуровневую структуру, в каждом слое которой расположены НЭ с насыщением. Число НЭ в верхнем и нижнем слоях одинаково и равно числу классов образов. Веса связей и пороги НЭ задаются при обучении ИНС Хемминга.

После задания весов связей и порогов НЭ на входы ИНС подается двоичный N-мерный вектор (образ). Он должен сохраняться на входах в течение времени, достаточного для параллельного срабатывания всех НЭ нижнего слоя и инициализации НЭ верхнего слоя. Каждый НЭ нижнего слоя вычисляет следующую величину N - Hi, где Hi - расстояние Хемминга между входным вектором и i-м эталоном.

После удаления входного вектора с входов ИНС состояние НЭ нижнего слоя не изменяется, а в верхнем слое происходит синхронное срабатывание НЭ.

Верхний слой осуществляет выбор НЭ с наибольшим уровнем возбуждения.

Критерием окончания процесса классификации служит отсутствие выходных cигналов на выходах всех НЭ верхнего слоя, за исключением одного. Номер этого НЭ соответствует классу, к которому принадлежит искаженный шумом входой образ.

По сравнению с ИНС Хопфилда ИНС Хемминга:

- требует почти на порядок меньшего числа соединений между НЭ при одинаковой информационной емкости сети;

- в процессе работы всегда "сходится" (эволюционирует) к некоторому эталонному образу.

Порогово-полиномиальные нейросети

Порогово-полиномиальная ИНС предназначена для распознавания сложных (линейно не разделимых) классов образов, заданных в n-мерном пространстве двойных признаков [4], [5].

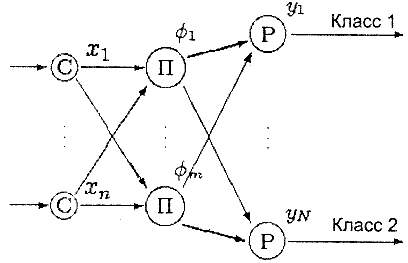

Рис. 3.13. Архитектура порогово-полиномиальной ИНС

Схема порогово-полиномиальной ИНС изображена на рис. 3.13.

На входе ИНС имеется сенсорный блок пороговых НЭ (С-элементов), фиксирующий признаки объектов х = (xj, ..., хn) в виде двоичных кодов.

Полученный входной образ (двоичный вектор х) поступает на блок полиномиальных преобразователей (А-элементов), формирующий m-мерный вектор вторичных (полиномиальных) признаков z = (ф1(х), ..., фm(х)).

Эти вторичные признаки определяют m-мерное пространство полиномиальных фj(х), j = 1...m, признаков, называемое спрямляющим пространством. Явный вид функций фj(х) выбирается адекватно решаемой задаче непосредственно по обучающей выборке.

В выходном слое расположены решающие пороговые НЭ (Р-элементы), каждый из которых "отвечает" за распознавание одного из классов объектов.

В библиотеку

В библиотеку