Косвенным недостатком многоступенчатого прогноза вперед является накопление ошибок. Для того, чтобы решить эту проблему и улучшить потенциал адаптивной временной задержки нейронных сетей (ATNN) для прогнозирования, представлена трехступенчатая модель прогнозирования SATNN на основе сплайн-интерполяции и ATNN. С помощью сплайн-интерполяции и ATNN, воздействие последней ошибки прогноза, которая будет повторно использоваться в модели для прогноза следующего шага уменьшается, а затем может быть получен лучший прогноз. Для тестирования многоступенчатой модели прогнозирования выбраны ежегодные солнечные пятна, рассматриваемые в качестве примера хаотической нелинейной системы. Проверка исследования показывает, что предложенная модель является достаточно эффективной в многоступенчатых прогнозах.

Введение

Многоступенчатый прогноз как один из видов алгоритмического прогнозирования, это полученное прогнозируемое значение в определенный промежуток времени на основе данных предыдущих измерений. Существующим на данный момент способом реализации многоступенчатых прогнозов на шаг вперед, является увеличение количества известных значений перед моментом прогноза., Для увеличения шага прогнозирования выборка из последних известных элементов постепенно увеличивается, что приводит к ухудшению результатов прогнозирования.

Существует множество литературы, в которой описано применение нейронных сетей для многоступенчатого прогноза [1-18], но большинство из алгоритмов слишком сложные и долго выполняются. Особенно медленно они сходятся при работе с большими объемами данных, точность прогноза в таком случае тоже не очень высока. Метод многоступенчатого прогноза эффективно применяется в рекуррентных нейронных, но в таком случае требуется длительное обучение сети, а надежность результатов остается на довольно низком уровне.

Временная задержка нейронных сетей (TDNN) и ее усовершенствованная модель –адаптивная временная задержка нейронных сетей (ATNN) успешно применяются в нелинейных системах идентификации [14], по сравнению с рекуррентной нейронной сетью они быстро обучается и легко реализуемы. Эта работа направлена на изучение возможности многоступенчатых прогнозов с адаптивной временной задержкой нейронной сети и алгоритма этой задержки. С помощью техники сплайн-интерполяции, были выбраны такие исходные данные для прогноза, чтобы воздействие наблюдаемых значений в модели было усилено, а затем улучшено с помощью многоступенчатого прогноза.

Цель работы

Целью данной работы является разработка и анализ метрики для

оценки степени близости объектов во взвешенных обучающих выборках.

1. Модель и алгоритм

1.1. Архитектура модели

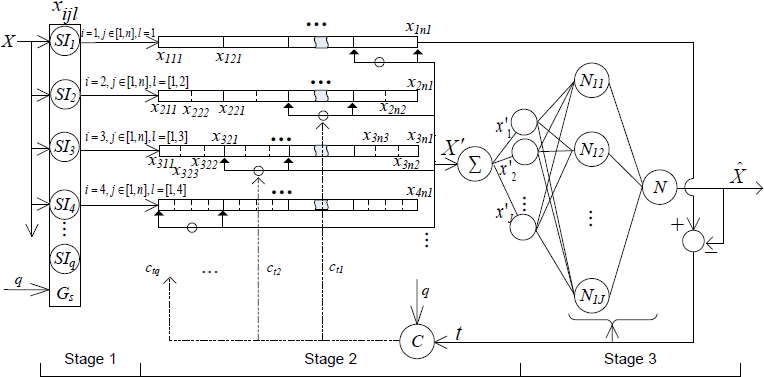

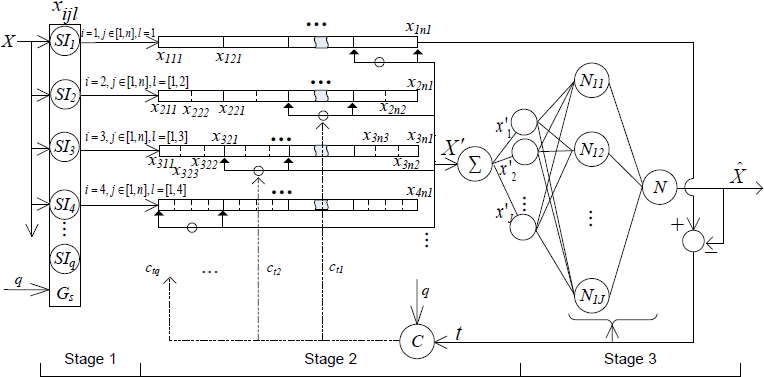

Архитектура модели и алгоритм схемы представлены на рисунке 1. На первом этапе Gs является генератором блоков сплайн-интерполяции, он может производить несколько виртуальных последовательностей. На втором этапе, определенные данные выбираются из результирующей последовательности интерполяции единиц, для формирования новой последовательности. На третьем этапе, ATNN используется для прогноза для новой последовательности.

Рисунок 1 – Трехступенчатая архитектура модели прогнозирования SATNN

1.2. Алгоритм

На первом этапе, различные блоки интерполяции, используют разные частоты дискретизации вставленных сглаженных исходных данных. Пусть D исходная частота дискретизации, тогда используя частично-полиномиальные функции третьего порядка B-сплайн-интерполяцию можно охарактеризовать как:

где

k′точки интерполяции, N – длина исходной последовательности, оператор * обозначает свертку, а Q является количеством единиц B-сплайн интерполяции.

Когда модель прогнозируется в начальной точке xt+p, если р>1, прогностическая ценность очень сильно зависит от начальных условий, так что используя метод интерполяции на втором этапе, последовательность X "порождается динамически из исходных данных. Эта последовательность может быть выражена как

где

t представляет текущее время, J обозначает длину последовательности.

В результате требуется обучение модели, на интервалe t∈[p+1,n]

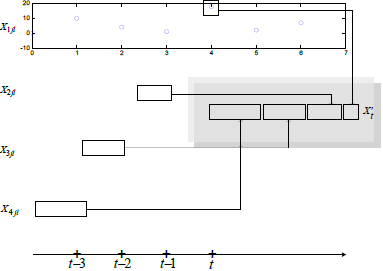

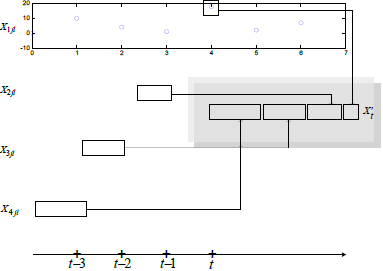

Если t разные, то X′ динамическая последовательность. После объединения интерполяции и динамических комбинаций, исходные данные теряют свой смысл. Следующая стадия модели в основном ориентирована на порядковый номер в очереди X′. На рисунке 2 показана схема интерполяции и динамических сочетаний (возьмем q=4).

Рисунок 2 – Последовательность после второго этапа

На основе первых двух этапов, многоступенчатый прогноз можно представить в виде

где 0≤τ≤J-1 переменные с "^" Экспресс-прогностической ценностью. На третьем этапе, <>l<>-sq слой ATNN имеет NL нейронов. Входной и результирующая согласующие для адаптивного нейрона представляются как

Пусть вес нейрона wi, τ время задержки а σ(.) означает нелинейную функцию активации. Отсюда модель прогнозирования с одним скрытым слоем выражается как

где 0≤τjil≤J-1, ojl(t)=σl(netjl(t)), выход j-го нейрона на l-м слоезаписывается как ojl(t). Значение {ojl(t)|x′t-i,0≤i≤J-1}это выход i-го нейрона первого слоя, и x′t+1=xt+1 это прогнозное значение xt+1

2. Эксперименты и обсуждение

Для того чтобы проверить обоснованность модели, протестируем временной ряд: среднее число ежегодичных пятен на солнце. Эта последовательность является классическим примером статистики, и является пробной выборкой для тестирования различных методов моделирования [5, 6, 19].

Топология ATNN третьего этапа состоит из трех слоев ВР сети, содержащей один скрытый слой, его конструктивные параметры такие: максимальная задержка 4, &taumax=10, количество входных узлов точек ATNN 10 [20, 21].Номер узла скрытого слоя может быть получен из эксперимента (возьмем 13).

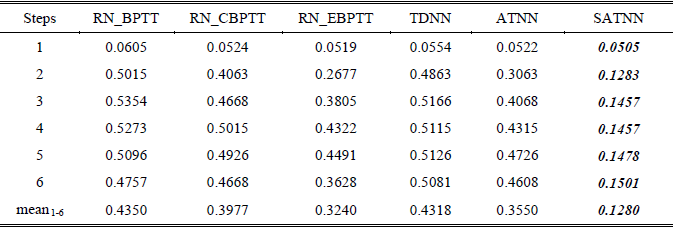

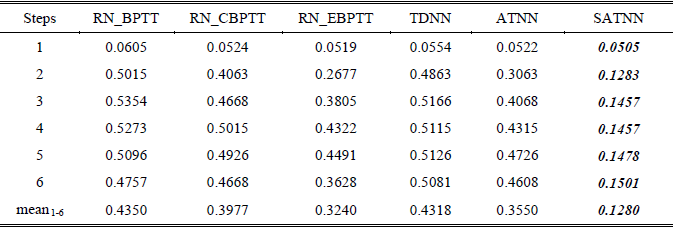

Для того, чтобы убедиться в справедливости SATNN, 40 были проведены эксперименты для Set1 и Set2 используя только имеющиеся литературные данные и модели для сравнения, без имитационных моделей. Таблица 1 является для Set1 моделью ошибки прогноза.

Таблица 1 – Сравнение шести алгоритмов для Set1

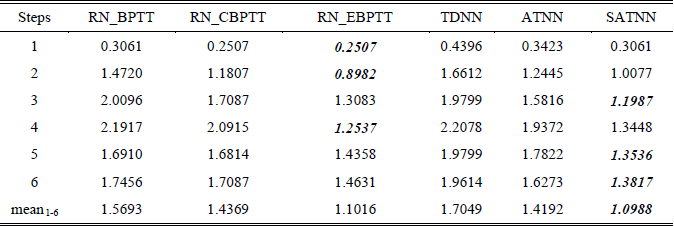

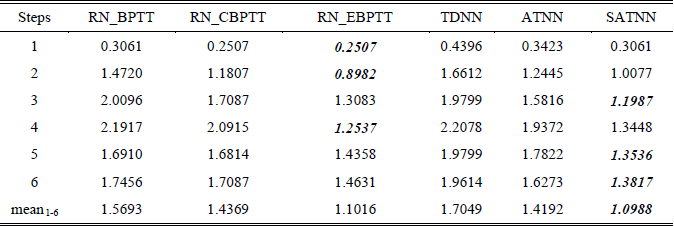

Таблица 2 является для Set2 моделью ошибки прогноза.

Таблица 2 – Сравнение шести алгоритмов для Set2

Таким образом, посредством преобразования данных интерполяции, ATNN эффективно улучшает многоступенчатую прогнозную способность рекурсивной нейронной сети с относительно простой структурой.

Выводы

Учитывая внедрение сплайн-интерполяции, времени задержки и динамической задержки нейронной сети, эта работа представляет собой комбинированную трехступенчатую модель прогнозирования. На первом этапе, через несколько блоков интерполяции генерируются интерполяции последовательностей различных чисел, на втором этапе получают несколько новых динамических последовательностей; на заключительном этапе с помощью адаптивной временной задержки нейронной сети прогноз завершается. Результаты двух тестов на временных рядах показывают, что модель многоступенчатого прогноза реальна и эффективна. Открытая и развитая комбинированной модель воплощает в себе преимущества различных уже существующих алгоритмов. Кроме того, эта модель может быть улучшена, например, использованием иммунного алгоритма задержки и оптимизацией сетевой структуры, тем самым будут улучшены адаптивные возможности ATNN и точность прогноза.

Список использованной литературы

1. Aussem, “Dynamical recurrent neural networks towards prediction and modeling of dynamical systems”, Neurocomputing, Vol.28, No.1-3, pp.207-232.

2. R. Bone, M. Crucianu, “Multi-step-ahead prediction with neural networks: a review”, 9emes rencontres Internationales ‘Approches Connexionnistes en Sciences Economiques et

en Gestion’, Publication de l'equipe RFAI, November 21-22, 2002, pp. 97-106.

3. R. Bone, M. Crucianu, J.-P de Beauville, “Two constructive algorithms for improved time-series processing with recurrent neural networks”, Neural Networks for Signal Processing- Proceedings of the 2000 IEEE Workshop, Vol.1, IEEE Conference Publishing Services, December 11-13, 2000, pp.55-64.

4. H-G Choi, H-S Lee, S-H Kim, et al, “Adaptive prediction of nonstationary signals using chaotic neural networks”, IEEE World Congress on Computational Intelligence, IEEE Conference Publishing Services, May 4-9, 1998, pp.1943 – 1947.

5. A.J Conway, K.P Macpherson, G. Blacklaw, et al, “A neural network prediction of solar cycle 23”, Journal of Geophysical Research-space Physics, Vol.103, No.A12, pp.29733-29742.

6. A.J Conway, K.P Macpherson, J.C Brown, “Delayed time series predictions with neural networks”, Neurocomputing, Vol.18, No.1-3, pp.81-89.

7. A.B Geva, “ScaleNet-multiscale neural-network architecture for time series prediction”, IEEE Transactions on Neural Networks, Vol.9, No.6, pp.1471-1482.

8. M Han, J H Xi, S Xu, et al, “Prediction of chaotic time series based on the recurrent network”, IEEE Transactions on Signal Processing, Vol.52, No.12, pp.3409-3416.

9.N Karunanithi, WJ Grenney, D Whitley, et al, “Neural networks for river flow prediction”, Journal of Computing in Civil Engineering, Vol.8, No.2, pp.201-220.

10.A.A.M Khalaf, K. Nakayama, “Time series prediction using a hybrid model of neural network and FIR filter”, Proceedings of the 1998 IEEE International Joint Conference on Neural Networks, Vol.3, IEEE Conference Publishing Services, May 4-9, 1998, pp.1975 - 1980.

11.S.S Kim, “Time delay recurrent neural network for temporal correlations and prediction”, Neurocomputing, Vol.20, No.1-3, pp.253-263.

12.S.G Kong, “Time series prediction with evolvable block-based neural networks”, Proceedings of 2004 IEEE International Joint Conference on Neural Networks, Vol.2, IEEE Conference Publishing Services, July 25-29, 2004, pp.1579 - 1583.

13.D.W Lee, K.B Sim, “Evolving chaotic neural systems for time series prediction”, Proceedings of the 1999 Congress on Evolutionary Computation, Vol.1, IEEE Conference Publishing Services, July 6-9, 1999, pp.310-316.

14.T.M Martinetz, S.G Berkovich, K.J Schulten, “Neural-gas network for vector quantization and its application to time-series prediction”, IEEE Transactions on Neural Networks, Vol.4, No.4, pp.558 - 569.

15.T.M Martinetz, S.G Berkovich, K.J Schulten, “Neural-gas network for vector quantization and its application to time-series prediction”, IEEE Transactions on Neural Networks, Vol.4, No.4, pp.558 - 569.

16.Schenker B, Agarwal M. (1995). “Long-range prediction for poorly-known systems”, International Journal of Control, Vol.62, No.1, pp. 227-238.

17.H.T Su, T.J McAvoy, P. Werbos, “Long-term predictions of chemical processes using recurrent neural networks: a parallel training approach”, Industrial & Engineering Chemical Research, Vol.31, No.5, pp.1338-1352.

18.D. Shi, H.J Zhang, L.M Yang, “Time delay neural network for the prediction of carbonation tower's temperature”, IEEE Transactions on Instrumentation and Measurement, Vol.52, No.4, pp.1125-1128.

19.A.J Conway, “Time series, neural networks and the future of the Sun”, New Astronomy Reviews, Vol.42, No.5, pp.343-394.

20.D.T. Lin, J.E Dayhoff, P.A Ligomenides, “Trajectory production with the adaptive time delay neural network”, Neural Networks, Vol.8, No.3, pp.447-461.

21.A. Yazdizadeh, K. Khorasani, “Adaptive time delay neural network structures for nonlinear system identification”, Neurocomputing, Vol.47, pp. 207-240.