Реферат по теме выпускной работы

Содержание

- Введение

- 1. Актуальность темы

- 2. Цель и задачи исследования, планируемые результаты

- 3. Обзор существующих методов автоматического реферирования

- 3.1 Подходы и методы автоматического реферирования

- 3.2 Экстрактивные методы

- 3.2.1 Статистические методы

- 3.2.1.1 Метод Луна (Luhn)

- 3.2.1.2 Метод ACSI-Matic (Assistant Chief of Staff for Intelligence, Automatic)

- 3.2.1.3 Метод Освальда

- 3.2.1.4 Методы статистических ассоциаций

- 3.2.2 Логико-математические методы

- 3.2.3 Дистрибутивный метод

- 3.2.4 Метод содержательных аспектов

- 3.2.5 Метод текстовых связей

- 3.3 Методы с опорой на знания

- 4. Обзор существующих разработок

- 4.1 Intelligent Text Miner

- 4.2 Inxight Summarizer

- 4.3 Золотой ключик

- 4.4 TextAnalyst

- 4.5 МЛ Аннотатор

- 4.6 Extractor

- Выводы

- Список источников

Введение

Использование компьютеров и появление сети Internet дают возможность быстро получать и публиковать любую информацию, что, с одной стороны, ускоряет поиск необходимых данных, и повышает эффективность работы человека с различными видами информации, но, с другой стороны, такое развитие информационных технологий обусловило переход общества к новому типу – информационному. В таких условиях объемы информации выросли в десятки раз и продолжают расти дальше, превышая человеческие возможности воспринимать и обрабатывать такое количество информации.

Основную часть знаний человек получает путем анализа, сравнения и синтеза информации из разрозненных источников, чаще всего представленных текстом. Объем новых знаний, приобретаемых человеком в процессе изучения текстов, доходит до 85 %. Научно-технический прогресс привел к появлению большого числа публикаций (книг, статей и т.п.) по самым разным проблемам науки, техники, образования, и специалисты не успевают следить за новейшей литературой по своей области знания. Открытые источники информации позволяют получить доступ к большому числу различных публикаций, что приводит к появлению проблемы эффективной работы с огромными объемами данных.

Реферирование текста являются сложным видом интеллектуальной деятельности. Составление человеком рефератов занимает много времени. Процесс автоматического реферирования текстовой информации позволяет заменить трудоемкий процесс выделения важной информации вручную. Формирование краткого смысла оригинальных текстов в виде рефератов в несколько раз повышает скорость анализа текстовых документов.

1. Актуальность темы

На современном этапе развития общества время является самым критическим ресурсом для человека. Человеку постоянно приходиться иметь дело с большим количеством различной информации, которую необходимо своевременно обрабатывать. Значительная часть такой информации представлена текстами на естественном языке. В случае, когда документов оказывается слишком много и человек не способен внимательно прочитать их в отведенное для этого время, на помощь приходят системы автоматического реферирования текстовых документов.

Реферирование текстов представляет собой одну из важнейших отраслей современных информационных технологий, поскольку количество информации, с которой приходится сталкиваться человеку, постоянно растет и приходит время, когда проработать весь необходимый материал становиться просто невозможным. Таким образом, разработка алгоритмов автоматического реферирования текстов не только не теряет своей актуальности, а напротив, становится все более необходимым в связи с постоянно возрастающим объемом текстовых данных.

2. Цель и задачи исследования, планируемые результаты

Целью данной работы является исследование задачи автоматического реферирования текста и поиск новых подходов к решению данной задачи с применением технологий на основе нечеткой логики. Проектируемая система автоматического реферирования текста позволит улучшить смысловое качество реферата и повысить эффективность процессов обработки данных и знаний в компьютерных системах, а также позволит хорошо обрабатывать тексты различных жанров, разного уровня сложности терминологии и объемов.

Основные задачи исследования:

- обзор современного состояния проблемы автоматического реферирования текстов;

- исследование методов реферирования текстов;

- обзор существующих систем реферирования текстов;

- рассмотрение аппарата нечеткой логики;

- разработка архитектуры проектируемой системы;

- разработка алгоритма автоматического реферирования текстов;

- разработка программного продукта, реализующего разработанный алгоритм автоматического реферирования текстов;

- выполнение сравнительного анализа предложенного алгоритма и известных алгоритмов решения данной задачи.

В результате выполнения работы должна быть разработана структура системы автоматического реферирования текста, выбраны методы и разработаны алгоритмы, которые необходимо реализовать в ее модулях, а также намечены пути улучшения качества работы разработанной системы.

3. Обзор существующих методов автоматического реферирования

3.1 Подходы и методы автоматического реферирования

История применения вычислительной техники для реферирования насчитывает уже более сорока лет и связана с именами таких исследователей, как Г.П. Лун [1], В.Е. Берзон [2], И.П. Севбо [3], Э.Ф. Скороходько [4], В.П. Леонов [5], Р.Г. Пиотровский [4] и многие другие. За эти годы были выработаны многочисленные подходы к решению данной проблемы [6].

Автоматическое реферирование (Automatic Text Summarization) – извлечения наиболее важных сведений из одного или нескольких документов и генерация на их основе лаконичных и информационно-насыщенных отчетов. Существует два направления автоматического реферирования – квазиреферирование и краткое изложение содержания. Краткое изложение исходного материала основывается на выделении из текстов с помощью методов искусственного интеллекта и специальных информационных языков наиболее важной информации и порождении новых текстов, содержательно обобщающих первичные документы [7].

Квазиреферирование основано на экстракции из первичных документов с помощью определённых формальных признаков «наиболее информативных» фраз (фрагментов), совокупность которых образует некоторый экстракт (квазиреферат). Собственно автоматическое реферирование же основано на выделении из текстов с помощью специальных информационных языков наиболее существенной информации и порождении новых текстов (рефератов), в большей или меньшей степени изоморфных первичным документам (или их частям) [6].

Квазиреферирование обладает той особенностью по сравнению с собственно реферированием, что основывается на анализе поверхностно-синтаксических отношений в тексте, которые выражены в нём и не требуют обращения к глубинно-семантическим процессам, изученность которых ещё явно недостаточна для описания свойств любого текста. Второе направление в настоящее время представлено экспериментальными исследованиями и до широкой реализации ещё не дошло[6].

3.2. Экстрактивные методы

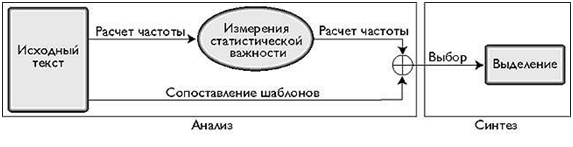

Экстрактивный метод предполагает акцент на выделение характерных фрагментов (как правило, предложений). Для этого методом сопоставления фразовых шаблонов, выделяются блоки наибольшей лексической и статистической релевантности. Создание итогового документа в данном случае – это соединение выбранных фрагментов [6].

В большинстве методов применяется модель линейных весовых коэффициентов [8]. Основу аналитического этапа в этой модели составляет процедура назначения весовых коэффициентов для каждого блока текста в соответствии с такими характеристиками, как расположение этого блока в оригинале, частота появления в тексте, частота использования в ключевых предложениях, а также показатели статистической значимости. Сумма индивидуальных весов, как правило, определённая после дополнительной модификации в соответствии со специальными параметрами настройки, связанными с каждым весом, даёт общий вес всего блока текста.

Одна группа метрик, например, метрика tf.idf, характеризует баланс между частотой появления термина в документе и частотой его появления в наборе документов (как правило, используется с другими метриками частоты и средствами нормализации длины) [9].

Этот метод был создан ещё в 60–70-х годах, но большинство систем, подготавливающих такого рода конспект на основе выдержек, до сих пор используют подход, проиллюстрированный на рисунке 1. Анализ сравнительных характеристик различных моделей, произведённый с целью определить производительность каждой, показал, что локализацию блоков текста можно считать одной из самых полезных функций, особенно в сочетании с функцией выявления ключевых фраз [6].

Рисунок 1 – Архитектура извлечения фрагментов текста (реферирование без опоры на знания)

Конечно, главное преимущество линейной модели заключается в простоте её реализации. Однако выделение предложений (или параграфов), не учитывающее взаимоотношений между ними, приводит к формированию бессвязных рефератов. Некоторые предложения могут оказаться пропущены, либо в них могут встречаться «висящие» слова или словосочетания (слово или фраза, которые невозможно понять без другого слова или фразы) [6].

3.2.1. Статистические методы

3.2.1.1 Метод Луна (Luhn)

Метод, предложенный в 1958 г. Г.П. Луном [1], считается классическим. Он предположил, что часто встречающиеся в тексте слова являются наиболее значимыми и чем больше часто встречающихся слов оказывается рядом, тем более существенную информацию содержит предложение.

Главный недостаток такого подхода: при использовании только частотного критерия полностью игнорируются смысловые связи между словами. При таком методе реферирования объём и качество рефератов полностью зависят от статистики текста, а предложения, содержащие наиболее важную информацию, могут вообще быть не выделены. Однако эти недостатки в известной степени компенсируются простотой анализа и однородностью получаемых рефератов [6].

3.2.1.2 Метод ACSI-Matic (Assistant Chief of Staff for Intelligence, Automatic)

В исследовании ACSI-Matic, статистический метод Луна был незначительно модифицирован [6].

Данный подход основывался на допущении, что представительными являются слова, частота встречаемости которых превосходит среднюю частоту слов в документе.

Затем для определения объёма реферата общее количество отобранных предложений (если их не более 200) делилось на 10, и объём реферата составлял 10 % от общего объёма документа. Предложения с большими весами подлежали включению в реферат, а со средним — помечались как «резервные». Нижний предел веса устанавливался экспериментальным путём.

При изучении избыточности информации в предложениях вводился следующий критерий; если число встретившихся в двух предложениях синонимов и близких по значению слов превышало 25 % от общего количества слов в предложении, то такие предложения считались избыточными и вычеркивались. В этом случае для реферата выбирались предложения из резерва. Этот процесс длился до тех пор, пока не устранялись избыточные или не заканчивались «резервные» предложения. Окончательный набор и представлял собой реферат.

Однако метод ACSI-Matic, несмотря на усовершенствованную процедуру отбора предложений, игнорировал смысловые связи между словами [6].

3.2.1.3 Метод Освальда

Отличие этого метода проявлялось в том, что В. Освальд и его сотрудники применили к отбору предложений для включения в реферат инструмент, применяемый при индексировании, а именно: предложения анализируемого текста сопоставлялись с заданными перечнями слов (или с группами слов, т.е. со словами, объединёнными по смыслу). Для включения в реферат отбирались предложения с наибольшим количеством совпавших с перечнем слов, а отобранные предложения далее обрабатывались по методу Г. Луна. Метод В. Освальда предусматривал следующие процедуры обработки документов [6]:

- выявление слов, отражающих содержание документа;

- выявление «мультитермов», т.е. устойчивых словосочетаний, при условии, что они встречаются в тексте чаще одного раза;

- выявление предложений с двумя и более мультитермами;

- расположение мультитермов в порядке частоты встречаемости;

- отбор предложений с наибольшим количеством основных слов и мультитермов.

3.2.1.4 Методы статистических ассоциаций

Идея В. Освальда о необходимости включать «мультитермы» была развита Л. Дойлом и М. Квиллианом, которые применили для отражения содержания документов ассоциативные методы создания семантически связанных групп (пучков) терминов (word clusters) [6].

В качестве основания для ассоциирования терминов было предложено использовать их совместную встречаемость в предложениях. На основании совместной встречаемости слов рассчитывался коэффициент подобия. Такой метод позволил использовать для отражения содержания не только основные термины, но и другие элементы текста.

Подход Л. Дойла базировался на статистических критериях построения ассоциативных карт с помощью ЭВМ. Созданию карты предшествовало создание исходной матрицы (ключевые слова текста) и матрицы взаимосвязанных элементов.

Метод другого исследователя, М. Квиллиана, несколько отличается от метода Л. Дойла. В противоположность статистическому методу, М. Квиллиан предложил использовать не ассоциативные карты, составленные на основе статистических показателей, а семантические карты. При этом учитывались взаимосвязи не между отдельными словами, а между информативными концептами [6].

3.2.2. Логико-математические методы

Методы Эдмундсона-Виллиса (Edmundson-Wyllys). В 1961–1963 гг. Г. Эдмундсон и Р. Виллис критически рассмотрели существующие способы оценки качества рефератов: интуитивный метод; метод построения модели «идеального» реферата; «анкетный» метод; оценку поисковых возможностей реферата; метод статистической корреляции, применяемый при автоматической обработке текста [6].

Дальнейшее развитие этих методов заключалось в обосновании логико- математической концепции отбора предложений. В соответствии с данной концепцией, Г. Эдмундсон и Р. Виллис предложили четыре взаимодополняющих метода, которые они назвали «Методом намёка» (Cue method), «Методом ключевых слов» (Key method), «Методом заглавия» (Title method) и «Методом определения места» (Location method).

Наиболее эффективным оказалось совместное использование методов намёка, заглавия и местонахождения (30–60 %). Исходя из этих результатов, Г. Эдмундсон и Р. Виллис обосновали отказ от применения метода ключевых слов для отбора предложений в процессе реферирования. Результаты описанных исследований представляют интерес по ряду причин. В частности, стало очевидно, что за успехами предыдущих экспериментов не последовали ожидаемые практические результаты, поскольку эти эксперименты проводились на ограниченных массивах специально подобранных текстов. Программы, рассчитанные на подобные тексты, заранее гарантировали успех. Авторы особо обратили внимание на необходимость дальнейших исследований по синтаксическому и семантическому анализу текстов [6].

3.2.3. Дистрибутивный метод

Метод Эрла (Earl) [6]. Эксперименты в 1965–1971 гг. под руководством Л. Эрла. В ходе этих исследований особое внимание обращалось на лингвистические проблемы обработки документальной информации, в частности, на роль морфологической, фонетической и синтаксической структуры английского языка. Кроме Л. Эрла, в состав группы входили ученые-лингвисты: Г. Резников (Resnikoff), Дж. Долби (Dolby), Г. Робинсон (Robinson), Б. Рудин (Rudin), О. Фиршейн (Firshein) и М. Фишлер (Fischler).

Если в ходе эксперимента группа предложений, отобранных для анализа, признавалась потенциальным источником индексируемых терминов (indexable), то синтаксические структуры этих предложений тщательно изучались. Исследование должно было подтвердить или опровергнуть сходство полученных синтаксических структур с потенциально пригодными для индексирования синтаксическими структурами предложений из заранее составленного списка. Полученные структуры, помеченные index или nonindex, входили в словарь частей речи. Однако первые эксперименты показали, что, основываясь только на анализе синтаксических структур, нельзя выделить предложения для реферата и индексирования.

3.2.4. Метод содержательных аспектов

Метод Раша. Метод автоматического реферирования документов (Automatic Document Abstracting Method – ADAM), разработанный группой Дж. Раша и реализованный на ЭВМ IBM-370, предусматривал выполнение следующих условий [6]:

- объём машинного реферата не должен превышать 10 % объёма первичного документа;

- в реферате используется та же лексика, что и в первичном документе;

- количественные показатели опускаются (кроме тех, которые являются результатом исследования);

- предварительные и негативные замечания, уравнения, сокращения, объяснения, цитаты, таблицы, чертежи, ссылки и т.п. не подлежат включению в реферат.

Включению в реферат подлежали предложения, содержащие информацию о цели и результатах исследования и о выводах автора. Следовательно, основная задача заключалась в том, чтобы выявить такие предложения.

3.2.5. Метод текстовых связей

Метод Берзона. Под влиянием когнитивной психологии постулировалось, что информационная значимость предложения в тексте может определяться не только статистическими свойствами его компонентов, но и характером и числом его связей с другими предложениями. На этом принципе построены модели автоматического реферирования, разработанные В.Е. Берзоном [2], а также С.М. Приходько [10], Э.Ф. Скороходько [4], И.П. Севбо [3] и др.

В соответствии с одним из методов для отбора информационно наиболее значимых предложений задаётся некоторая пороговая величина, выражающая число связей. Регулируя эту величину, можно менять информационную насыщенность предложений и, следовательно, объём реферата. При этом характер самих предложений может не приниматься во внимание [6].

Другой, более сильный вариант этого метода заключается в том, что в тексте разграничиваются эксплицитные и имплицитные сверхфразовые единицы. При этом оказывается, что основное содержание несёт обычно первое предложение эксплицитной сверхфразовой единицы. Это предложение, как правило, является автосемантичным. Информативность первого предложения эксплицитной сверхфразовой единицы возрастает при увеличении длины этой единицы. К числу информативных также относятся крайние предложения с многократными покрытиями, под которыми понимаются перекрывающие межфразовые связи [11].

Учёт параметра межфразовых связей делает результирующий реферат более связным и целостным [6].

3.3. Методы с опорой на знания

В отличие от линейной модели в методах подбора выдержек, для подготовки краткого изложения информации, требуются мощные вычислительные ресурсы для систем обработки естественных языков (NLP – natural language processing), в том числе грамматики и словари для синтаксического разбора и генерации естественно-языковых конструкций. Кроме того, для реализации этого метода нужны некие онтологические справочники, отражающие соображения здравого смысла и понятия, ориентированные на предметную область, для принятия решений во время анализа и определения наиболее важной информации [8].

Как показано на рисунке 2, метод формирования краткого изложения предполагает два основных подхода.

Первый (вверху) опирается на традиционный лингвистический метод синтаксического разбора предложений [6]. В этом методе применяется также семантическая информация для аннотирования деревьев разбора. Процедуры сравнения манипулируют непосредственно деревьями с целью удаления и перегруппировки частей, например, путём сокращения ветвей на основании некоторых структурных критериев, таких как скобки или встроенные условные или подчинённые предложения. После такой процедуры дерево разбора существенно упрощается, становясь, по существу, структурной «выжимкой» исходного текста [8].

Рисунок 2 – Два основных подхода метода формирования краткого изложения

Второй подход к составлению краткого изложения уходит корнями в системы искусственного интеллекта и опирается на понимание естественного языка [12]. Синтаксический разбор также входит составной частью в такой метод анализа, но деревья разбора в этом случае не порождаются. Напротив, формируются концептуальные репрезентативные структуры всей исходной информации, которые аккумулируются в текстовой базе знаний. В качестве структур могут быть использованы формулы логики предикатов или такие представления, как семантическая сеть или набор фреймов.

В процессе преобразования концептуальное представление претерпевает несколько изменений. Избыточная и не имеющая прямого отношения к тексту информация устраняется путём удаления поверхностных суждений или отсечения концептуальных подграфов. Затем информация подвергается дальнейшему агрегированию путём слияния графов (или шаблонов) или обобщения информации, например, при помощи таксономических иерархий отношений подклассов. В результате преобразования формируется концептуальная репрезентативная структура реферата, по существу, концептуальные «выжимки» из текста [6].

Наличие этих формальных репрезентативных слоев (структурные и концептуальные «выжимки») отличает подход, основанный на базе знаний, от подхода, не предполагающего опору на знания. Как видно из рисунков 1 и 2, этап синтеза одинаков для обоих подходов: текстовый генератор преобразует структурное или концептуальное представление в естественно-языковую аннотацию. Некоторые системы предоставляют пользователю возможность управлять получаемыми «выжимками» методом указания, и не предполагают этапа генерации, при условии, что исходные тексты предоставляются наряду с их кратким изложением. Этот тип реферирования опирается на предварительно определенные структуры знаний, которые заранее указывают системе реферирования, какую концепцию считать более характерной, или какие концептуальные свойства (роли или поля) имеет та или иная концепция. Средство реферирования полностью представляет семантическую информацию в виде связей между узлами в концептуальном графе, как таксономические (подкласс или экземпляр) или метонимические (часть) отношения. В этом случае, он также задает направление и критерии выбора для процедуры поиска или формирования заключений. Правила вывода на базе рефератов или общие схемы вывода (такие как терминологическая классификация) используют эту информацию для определения информации, наиболее точно отражающей существо текста. Эта информация определяет, какие иерархии обобщения должны быть пройдены и какие концептуальные подграфы могут быть при необходимости сжаты [8].

4. Обзор существующих разработок

4.1 Intelligent Text Miner

Продукт фирмы IBM Intelligent Miner for Text представляет собой набор отдельных утилит, запускаемых из командной строки или скриптов независимо друг от друга. Данная система является одним из лучших инструментов глубинного анализа текстов [13].

Эта файлово-ориентированная система использует статистический и эвристический подходы к анализу текстов. Включает пять программ, запускаемых независимо друг от друга [14]: идентификатор языка; экстрактор характеристик; аннотатор; категоризатор; кластеризатор. Идентификатор языка использует для анализа характерные для языка части слов. Экстрактор характеристик извлекает из текста термины, имена, отношения, многословные термины, даты и выражения, обозначающие время. Для их извлечения используются специальные языковые эвристики. С целью увеличения корректности обработки пользователь может создавать персональный словарь. Аннотатор работает с помощью ранжирования слов и использует для этого слова, содержащиеся в названиях документа и заголовках, а также, статистику появления слов в сочетании со статистикой этих слов в персональном словаре пользователя. В отличие от других программ, категоризатор должен быть обучен перед использованием. Для этого предварительно статистически обрабатывается выборка текстов на заданную тему, а с целью более корректной оценки тематики выборки применяется морфологический анализ. Сформированная тематическая схема далее используется при анализе текстов для их категоризации. Кластеризатор не требует обучения и поддерживает два типа кластеризации: иерархическую и бинарных отношений (попарных связей). Первая формирует древовидную структуру, листья которой соответствуют отдельным документам, а ветви объединяют документы в более крупные множества, иерархически вложенные друг в друга. В бинарной кластеризации каждый документ может содержаться только в одном кластере, а кластеры могут связываться между собой на основе общности характеристик, выделенных экстрактором [15].

4.2 Inxight Summarizer

На рынке присутствует очень небольшое количество традиционных программ реферирования, то есть таких, которые выделяют наиболее весомые предложения из текста используя статистические, алгоритмы, либо слова-подсказки. Inxight Summarizer [16] – одна из наиболее известных коммерчески распространяемых систем реферирования. Inxight Summarizer был создан в Исследовательском центре Ксерокса в Пало Альто. Причин успеха данной системы несколько:

- Наличие одного из наиболее совершенных алгоритмов оценки качества реферата.

- Параллельное использование нескольких широко известных алгоритмов реферирования; непосредственная связь между алгоритмами реферирования и алгоритмом оценки качества реферата.

- Продажа не готовых программных продуктов, а модулей реферирования (динамических библиотек для Win32 и Solaris платформ).

Среди коммерческих систем также можно отметить Prosum – систему реферирования, разработанную British Telecommunications Laboratories в рамках экспериментальной коммерческой он-лайн платформы TranSend и представляет собой cgi-скрипт, встроенный в веб-страницу. Каждый реферат стоит 0,25 пенсов и оплачивается с помощью кредитных карточек MicroCredit.

Так как интерес к традиционным системам автоматического реферирования неуклонно снижается, многие компании предлагают другие подходы. Одним из нетрадиционных решений является использование именных групп, выделенных с помощью частичных синтаксических анализаторов. подобные алгоритмы используются в программных продуктах Extractor и TextAnalyst [17].

4.3 Золотой ключик

Это программная библиотека, работающая по принципу фильтрации на базе тезауруса. Как входные данные программе подается произвольный текст на русском языке, на стандартном выходе программа формирует аннотацию данного текста и список рубрик, к которым относится данный текст. В качестве аннотации используются предложения из входного текста, наиболее полно отражающие тематику текста. При рубрикации текста используется фиксированный список заранее определенных рубрик [18].

4.4 TextAnalyst

Программа создана в Московском Научно-производственном Инновационном Центре «МикроСистемы» [17]. TextAnalyst работает только с русским языком, выделяя именные группы и строя на их основе семантическую сеть – структуру взаимозависимостей между именными группами.

Программа TextAnalyst от Московского Научно-производственного Инновационного Центра «МикроСистемы» является инструментом для анализа содержания текстов, смыслового поиска информации и формирования электронных архивов [19].

Она также способна строить семантические деревья, но не по объектам, а по отдельным статьям, в результате чего создается смысловой портрет каждого текста в терминах основных понятий и их смысловых связей в виде иерархии тем и подтем конкретной статьи. В TextAnalyst есть также модуль, автоматически генерирующий реферат текстового документа в терминах наиболее информативных фраз. Программа не предназначена для потоковой обработки материалов СМИ, но может брать с диска файлы в формате txt и rtf и после анализа текста сохранять результаты в отдельном файле [20].

4.5 МЛ Аннотатор

Программа составляет связный реферат документа. Относительный размер реферата («коэффициент сжатия») задаётся пользователем. Программа имеет два режима работы: собственно реферирование и выделение ключевых слов. В режиме реферирования из текста отбираются предложения, в наибольшей степени характеризующие его содержание. В режиме выделения ключевых слов производится выборка из текста наиболее информативных слов. Программа выделяет в тексте значимые и шумовые слова, самостоятельные и зависимые предложения, определяет семантический вес предложений и удаляет незначащие фрагменты. Отобранные предложения при необходимости слегка перефразируются [18].

Используются специальные вероятностные модели, машинная морфология русского языка и другие интеллектуальные алгоритмы.

Существующие системы автореферирования являются дискретными, что дает стимул для создания непрерывной (многодокументных) системы автореферирования, что необходимо для обработки набора Internet-документов в базе данных поисковой системы. В Хакасском государственном университете им. Н.Ф. Катанова разработан метод симметричного реферирования [21] (основан на тематических словарях [18]), который позволяет применять систему автоматического непрерывного реферирования в совокупности с автоматическими информационно-поисковыми системами для обеспечения достаточной точности и релевантности поиска.

4.6 Extractor

Программа создана в Институте Информационных Технологий Национального исследовательского Совета Канады. Он представляет собой модуль, выделяющий из представленного ему на вход текста наиболее информативные именные группы. По умолчанию количество таких групп – 7 вне зависимости от длины текста. Extractor используется в программных продуктах фирм ThinkTank Technologies и Tetranet, а также в поисковой системе Журнала Исследований в Области Искусственного Интеллекта [17].

Выводы

В данной работе были исследованы существующие методы и подходы к решению задачи автоматического реферирования текстов, были проанализированы их достоинства и недостатки, а также выявлена потребность в применении современных технологий в данной области. Проведенные исследования методов, лежащих в основе современных систем автоматического реферирования позволили сделать следующие выводы:

- Задача автоматического реферирования включает в себя следующие подзадачи: выделение ключевых слов и фраз, поиск предложений, которые содержат ключевые слова и фразы, синтез на этой основе текста реферата.

- Системы автоматического реферирования текстов включают в себя выполнение трех основных этапов: анализ входного текста (предобработка, подготовка данных); анализ содержания документа, при котором определяются ключевые слова, отбрасывается избыточная и ненужная информация и др.; составление реферата из информации, полученной на предыдущем этапе.

Таким образом, для решения задачи автоматического реферирования текстов была показана актуальность использования алгоритма на основе нечеткой логики. При дальнейшей разработке данной темы следует рассмотреть также возможные пути применения нечеткой логики в системах автоматического реферирования текстов, а именно:

- Использовать теорию нечетких множеств в процессе формирования ключевых слов, словосочетаний и предложений, а также на этапе принятия решений при автоматическом реферировании текста.

- Разработать программный продукт, построенный на основе модели нечеткой логики для выполнения автоматического реферирования текста.

Список источников

- Luhn H. The automatic creation of literature abstracts. In IBM Journal of Research and Development, Vol. 2(2), 1958. – P. 159–165.

- Берзон В.Е. Синтаксические сверхфразовые связи и их инженерно-лингвистичекое моделирование / В.Е. Берзон (отв. ред. Р.Г. Пиотровский). – Кишинев: Штиинца, 1984. – 167 с.

- Севбо И.П. Структура связного текста и автоматизация реферирования / И.П. Севбо // М.: Наука, 1969. – 135 с.

- Скороходько Э.Ф. Семантические сети и автоматическая обработка текста / Э.Ф. Скороходько // К.: Наук. думка, 1983. – 220 с.

- Леонов В.П. О методах автоматического реферирования / В.П. Леонов // НТИ. Сер. 2. – 1975. – № 6. – С. 16–20.

- Луканин А.В. Автоматическая обработка естественного языка / А.В. Луканин; М-во образования и науки Российской Федерации, Южно-Уральский гос. ун-т, Каф. "Общая лингвистика". – Челябинск: Изд. центр ЮУрГУ, 2011. – 70 с.

- Гинкул А.С. Сравнительный анализ существующих систем автоматического реферирования текста / А.С. Гинкул // Політ. сучасні проблеми науки – Киев, 2012. – С. 255.

- Хан У. Системы автоматического реферирования / У. Хан, И. Мани // Открытые системы. – 2000. – № 12. – [Электронный ресурс]. – Режим доступа: http://www.osp.ru/os/2000/12/178370.

- Jurafsky D. Speech and Language Processing: An Introduction to Natural Language Processing, Computational Linguistics, and Speech Recognition / D. Jurafsky, J.H. Martin. — New Jersey: Prentice Hall, 2000. – 934 p.

- Приходько С.М. Автоматическое реферирование на основе анализа межфразовых связей / С.М. Приходько, Э.Ф. Скороходько // НТИ. – Сер. 2, № 1, 1982 – С. 27–31.

- Богданов В.В., Реферирование / В.В. Богданов // Прикладное языкознание: учебник. – СПб.: Изд-во С.-Петербург. ун-та, 1996. – С. 389–398.

- J. Hutchins, «Summarization: Some Problems and Methods» Proc. Informatics 9: Meaning-The Fron-tier of Informatics, K.P. Jones, ed., Aslib, London, 1987. – P. 151–173.

- Кутукова. Е.С. Технология Text mining/ Е.С. Кутукова// SWorld: Перспективные инновации в науке, образовании, производстве и транспорте. – Одесса, 2013.

- Dan Sullivan. Document Warehousing and Textmining. NY; Wiley publishing house, 2001. – P. 36–38.

- Харламов А.А. Автоматический структурный анализ текстов / А. Харламов. //Открытые системы. – 2002. – № 10. – С. 16–22.

- Kupiec J., Pederson J. and Chen F. A trainable document summarizer. In Proceedings of the 18th ACM/SIGIR Annual Conference on Research and Development in Information Retrieval, Seattle, 1995. – P. 68–73.

- А. Михаилян. Некоторые методы автоматического анализа естественного языка, используемые в промышленных продуктах, 2000. – [Электронный ресурс]. – Режим доступа: http://www.inteltec.ru/publish/articles/textan/natlang.shtml.

- Ступин B.C. Система автоматического реферирования методом симметричного реферирования / B.C. Ступин // Компьютерная лингвистика и интеллектуальные технологии. Труды межд. конференции «Диалог 2004». — М.: Наука, 2004. – С. 579–591.

- Моніторинг діяльності органів виконавчої влади із застосуванням комп’ютерної системи контент-аналізу електронних ЗМІ / Г. Леліков, В. Сороко, О. Григор’єв, Д. Ланде // Вісн. держ. служби України. – 2002. – № 2. – С. 21–38.

- Танатар Н.В., Федорчук А.Г. Интеллектуальные поисково-аналитические системы мониторинга СМИ / Н.В Танатар., А.Г. Федорчук // Научно-практический и теоретический сборник. – Киев, 2008. – 477 с.

- Iatsko V. Linguistic Aspects of Summarization // Philologie in Netz – № 18. – 2001. – P. 33–46. – [Электронный ресурс]. – Режим доступа: http://www.fu-berlin.de/phin/phin18/p18t3.htm.

Замечание

При написании данного реферата магистерская работа еще не завершена. Окончательное завершение: декабрь 2014 года. Полный текст работы и материалы по теме могут быть получены у автора или его руководителя после указанной даты.