Определение родного языка автора путем поиска ошибок в тексте

Автор: Moshe Koppel, Jonathan Schler, Kfir Zigdon

Источник: Moshe Koppel, Jonathan Schler, Kfir Zigdon. Determining an Author's Native Language by Mining a Text for Errors // Computer Science Department Bar-Ilan University Ramat-Gan, 52900, ISRAEL. https://citeseerx.ist.psu.edu/viewdoc/download?doi=10.1.1.113.7470&rep=rep1&type=pdf

Аннотация

В этой статье мы показываем, что стилистические особенности текста могут быть использованы для определения родного языка анонимного автора с высокой точностью. В частности, мы сначала используем автоматические инструменты для определения частоты различных стилистических особенностей в тексте. Эти частоты затем служат функциями для опорных векторных машин, которые учатся классифицировать тексты в соответствии с родным языком автора.

Категории и дескрипторы темы

I.2.6 [Artificial Intelligence]: Learning – Analogies, Concept learning, Connectionism and neural nets, Induction, Knowledge acquisition, Language acquisition, Parameter learning

Общие условия

Algorithms, Measurement, Experimentation

Ключевые слова

Text mining, author profiling

1 Введение

Стилистический анализ текста может предложить намек на психологическое или демографическое профилирование автора текста. Например, уже было показано, что методы автоматического анализа текста могут использоваться для определения пола анонимного автора с точностью выше 80% [1].

В этой статье мы покажем, что стилистические особенности могут быть использованы для определения родного языка автора данного текста на английском языке. На орфографию, грамматику и использование писателями второго языка часто влияют образцы их родного языка [2] [3]. Таким образом, вполне вероятно, что определенные шаблоны письма – выбор функционального слова, синтаксис и ошибки – могут быть особенно распространены среди носителей данного языка.

Некоторая работа [4] была проделана по классификации транскриптов английских речевых высказываний как носителей английского языка или не носителей английского языка. В наших экспериментах мы знаем, что автор не является носителем английского языка, но мы хотим определить, какой язык является родным для автора. Мы рассматриваем письменный текст, который предлагает преимущества грамматических и орфографических подсказок, но теряет преимущество неправильного произношения. Насколько нам известно, это первая опубликованная работа по автоматическому определению родного языка автора по письменному тексту.

2. Стилистические особенности

Определение родного языка автора – это одна из проблем, связанных с установлением авторства. Вместо того, чтобы идентифицировать конкретного автора из закрытого списка подозреваемых, мы хотим идентифицировать класс авторов, а именно тех авторов, которые говорят на определенном родном языке.

Исследователи атрибуции авторства обычно ищут те виды функций, использование которых примерно инвариантно для данного автора (или класса авторов) в разных темах, но которые могут варьироваться от одного автора (или класса авторов) к другому. Как правило, исследователи используют относительно общие наборы функций. Так, например, в основополагающей работе Мостеллера и Уоллеса [5] по атрибуции авторства в Записках федералиста

использовался набор из нескольких сотен функциональных слов, то есть слов, которые не зависят от контекста и, следовательно, вряд ли будут иметь предвзятость в отношении конкретных тем. Другие особенности, использованные в еще более ранней работе [6], основаны на сложности: средняя длина предложения, средняя длина слова, соотношение типа / токена и так далее. Последние технические достижения в области автоматизированного синтаксического анализа и тегирования части речи (POS) облегчили использование синтаксических и квазисинтаксических функций, таких как n-граммы POS [7] [8] [9] [10]. В другой недавней работе [11] рассматривается языковое моделирование с использованием буквенных n-грамм.

Однако люди (специалисты), работающие над проблемами установления авторства в реальной жизни, так не работают. Как правило, они ищут идиосинкразическое использование данного автора, которое служит уникальным отпечатком пальца этого автора. Например, Фостер [12] описывает свои методы идентификации множества печально известных анонимных авторов, включая автора романа Основные цвета

и Унабомбера

. Эти методы включают многократное использование определенных типов неологизмов или необычного использования слов. Примечательно, что Фостер выявляет эти лингвистические особенности вручную. В случае неотредактированных текстов также могут быть использованы орфографические и грамматические ошибки, которые обычно устраняются в процессе редактирования.

В этой статье мы будем использовать различные стилистические типы функций, которые могут быть полезны для определения родного языка автора. Очень грубо мы можем разбить эти типы функций на три большие категории.

- 1. Функциональные слова. Как отмечалось выше, функциональные слова полезны для указания авторства [5]. Само собой разумеется, что такие слова также могут быть полезны для идентификации на родном языке, поскольку определенные функциональные слова могут использоваться более или менее часто носителями данного языка, в зависимости от наличия или отсутствия аналогов для этих слов в данном язык. Хорошим примером является слово the, которое обычно реже используется носителями языков, таких как русский, без определенного артикля.

- 2. Буквенные n-граммы. Как уже отмечалось, буквенные n-граммы также оказались полезными для указания авторства [11]. Вероятно, что это просто артефакт переменного использования определенных слов, что, в свою очередь, может быть результатом различных тематических предпочтений. Однако в случае атрибуции на родном языке буквы n-граммы могут отражать орфографические правила родного языка автора (по крайней мере, для тех случаев, когда в родном языке используется латинский алфавит).

- 3. Ошибки и идиосинкразии. Как уже отмечалось, ошибки и идиосинкразии – это особенности, которые обычно используются экспертами по атрибуции, анализирующими данные вручную. Их полезность для атрибуции на родном языке очевидна: можно ожидать, что писатели перенесут орфографические или синтаксические соглашения со своих родных языков на английский таким образом, чтобы в результате получился нетрадиционный английский. Одним из основных вкладов этой статьи будет полная автоматизация процесса выявления идиосинкразии. Следующие два раздела статьи будут посвящены описанию.

- 1. Ортография. Здесь мы рассматриваем ряд орфографических ошибок следующим образом:

- Повторяющаяся буква (например, передать вместо передачи)

- Двойная буква появляется только один раз (например, выполнить вместо фиксации)

- Буква вместо (например, первая вместо первой)

- Инверсия букв (например, первая вместо первой)

- Вставленная буква (например, френд вместо друга)

- Отсутствующая буква (например, друг вместо друга)

- Объединенные слова (например, прилипшие вместе)

- Аббревиатуры

- 2. Синтаксис. Мы рассматриваем нестандартное использование следующим образом:

- Фрагмент предложения

- Продолжение предложения

- Повторяющееся слово

- Отсутствующее слово

- Несоответствие в единственном / множественном числе

- Несоответствующее время

- путаница

тот / какой

- 3. Неологизмы – чтобы использовать наблюдение Фостера [12] о том, что одни авторы склонны создавать неологистские прилагательные (например, fantabulous), в то время как другие создают неологистские глаголы, существительные и т. Д., Мы отмечаем для каждого POS (кроме имен собственных), полностью новые образцы (т.е. те, для которых нет близкого соответствия) этого POS.

- 4. Биграммы частей речи. Мы рассматриваем 250 редких POS-биграмм в корпусе Brown [16]. Такие пары могут считаться ошибочными или, по крайней мере, нестандартными. Chodorow и Leacock [15] отмечают ошибки при выставлении оценок эссе, проверяя те пары POS, которые появляются в корпусе реже, чем можно было бы ожидать, исходя из частоты отдельных POS, составляющих пару. Для наших целей стоит отметить любую редкую биграмму POS, которая появляется в тексте.

- 400 стандартных функциональных слов

- 200 буквенных n-граммов

- 185 типов ошибок

- 250 редких POS-биграмм

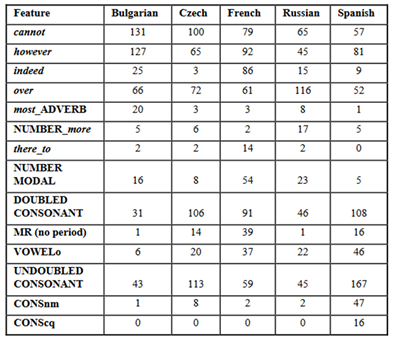

- Некоторые особенности, которые появляются в большем количестве документов в болгарском корпусе, чем в других корпусах, – это пара POS most – ADVERB, а несколько формальные функциональные слова не могут и, однако.

- Относительно большое количество авторов в испанском корпусе испытывало трудности с удвоением согласных, либо без надобности удвоением (исчезновение, полное заполнение, открытие), либо отказом от одного из двойных (эффект, интеллигентный). Некоторые ошибки, которые в корпусе испанского языка являются почти исключительными для авторов, напрямую связаны с правилами орфографии или произношения в испанском языке: путаница m и n (удобный) или q и c (cuantity, cuality).

- Относительно большое количество авторов документов в чешском корпусе также нестандартным образом удваивали буквы.

- Документы во французском корпусе характеризуются относительно частым употреблением этого слова, а также без точки и, как и в испанском корпусе, неправильным использованием гласной о (аутхор, психоделический). Номер пар POS – modal_verb (нужно, можно было) и there – to (каждому из них назначен свой POS в наборе тегов Brill) также чаще встречается во французском корпусе.

- Авторы в корпусе русского языка более склонны использовать слово over, а также пару POS NUMBER – more. Все приведенные выше примеры – это особенности, которые отличают один языковой корпус от всех остальных. Конечно, есть много особенностей, которые отличают одни подмножества языков от других. Например, частота употребления слова the значительно реже в документах чешских (47,0 на 1000 слов), русских (50,1) и болгарских (52,3) авторов, чем в документах французских (63,9) и испанских (61,4) авторов. (В русском и чешском языках не используется определенный артикль, а в болгарском языке он используется только как суффикс.)

- [1] Koppel, M., S. Argamon, A. Shimony. Automatically categorizing written texts by author gender. (2002) Literary and Linguistic Computing 17(4).

- [2] Lado,R. Linguistics Across Cultures, Ann Arbor: (1961) University of Michigan Press.

- [3] Corder, S. P. Error Analysis and Interlanguage. (1981) Oxford: Oxford University Press.

- [4] Tomokiyo, L.M. and R. Jones.

You're Not From 'Round Here, Are You? Naive Bayes Detection of Non native Utterance Text

(2001) NAACL 2001. - [5] Mosteller, F. and Wallace, D. L. Inference and Disputed Authorship: The Federalist. Reading, Mass. : Addison Wesley, (1964).

- [6] Yule, G.U. 1938. On sentence length as a statistical characteristic of style in prose with application to two cases of disputed authorship. Biometrika, 30, (1938) 363 – 390.

- [7] Baayen, H., H. van Halteren, F. Tweedie, Outside the cave of shadows: Using syntactic annotation to enhance authorship attribution.In

Literary and Linguistic Computing

, 11, (1996). - [8] Argamon-Engelson, S., M. Koppel, G. Avneri. Style-based text categorization: What newspaper am I reading?. in Proc. of AAAI Workshop on Learning for Text Categorization, (1998), pp. 1 – 4

- [9] Stamatatos, E., N. Fakotakis & G. Kokkinakis, Computer-based authorship attribution without lexical measures. Computers and the Humanities 35, (2001) pp. 193 – 214.

- [10] Koppel, M., J. Schler. Exploiting Stylistic Idiosyncrasies for Authorship Attribution. in Proceedings of

IJCAI'03 Workshop on Computational Approaches to Style Analysis and Synthesis

, (2003) Acapulco, Mexico - [11] Peng, F., D. Schuurmans, S. Wang. Augmenting Naive Bayes Classifiers with Statistical Language Models. Inf. Retr. (2004) 7(3 – 4): 317 – 345

- [12] Foster, D. Author Unknown: On the Trail of Anonymous, (2000) New York: Henry Holt.

- [13] Dagneaux, E., Denness, S. & Granger, S. Computer-aided Error Analysis. System. An International Journal of Educational Technology and Applied Linguistics. Vol 26 (2), (1998) 163 – 174.

- [14]Tono, Y., Kaneko, T., Isahara, H., Saiga, T. and Izumi, E. The Standard Speaking Test (SST) Corpus: A 1 million word spoken corpus of Japanese learners of English and its implications for L2 lexicography. Second Asialex International Congress, Korea, (2001) pp. 257 – 262

- [15]Chodorow, M. and C. Leacock. An unsupervised method for detecting grammatical errors, Proceedings of 1st Meeting of N. American Chapter of Assoc. for Computational Linguistics, (2000) 140 – 147

3. Типы ошибок

Пометка различных типов ошибок письма использовалась в ряде приложений, включая обучение английскому как иностранному (EFL) [13] [14] оценку сочинений учащихся [15] и, конечно же, обработку текстов. Используемые подходы либо частично ручные, либо не помечают типы ошибок, относящиеся к нашей задаче. Следовательно, мы разрабатываем наши собственные автоматизированные методы маркировки ошибок.

Наша первая задача – определить типы ошибок, которые мы хотим пометить. После этого мы покажем, как автоматизировать процесс добавления тегов. Типы ошибок, которые мы рассматриваем, попадают в следующие четыре категории:

Первые шесть из них представляют несколько типов ошибок, поскольку конкретная буква (буквы) указывается как часть ошибки. Например, отсутствующий i – это ошибка, отличная от отсутствующего n. Таким образом, в принципе Буква вместо

представляет 26 * 25/2 = 325 отдельных типов ошибок. Однако ниже мы увидим, что большинство из них происходит настолько редко, что мы можем рассматривать лишь небольшую их часть.

Следует подчеркнуть, что мы используем термин ошибка

или идиосинкразия

для обозначения нестандартного использования или орфографии в американском английском, хотя часто такое использование или орфография просто отражает различные культурные традиции или преднамеренный выбор автора.

Наша система поддерживает эти типы ошибок для использования в множество приложений, не рассматриваемых в данной статье. Эти ошибки не подходят для рассматриваемой здесь проблемы на родном языке, поэтому мы не используем их в описанных ниже экспериментах.

4. Автоматическая маркировка ошибок

Конечно, мы можем вызвать множество сложных типов ошибок, основанных на более глубоком лингвистическом анализе текста, помимо тех, что были представлены в предыдущем разделе. Однако мы ограничиваемся здесь теми, которые рассмотрены выше, потому что их можно относительно легко идентифицировать, как мы сейчас показываем.

Чтобы отметить ошибки в приведенном выше списке, мы используем существующие инструменты. Таким образом, для большинства типов ошибок в категориях 1 и 2 выше мы используем следующую процедуру:

Мы прогоняем текст через приложение MS Word и его встроенное средство проверки орфографии и грамматики. Каждая ошибка, обнаруженная в тексте средством проверки орфографии, записывается вместе с лучшим предложением (по исправлению ошибки), предлагаемым средством проверки. Каждая пара <ошибка, предложение> затем обрабатывается другой программой, которая присваивает ей тип ошибки

из числа тех, что находятся в созданном нами списке.

Очевидно, что автоматизированные средства проверки орфографии и грамматики далеки от совершенства: конечно, предлагаемые исправления могут не отражать намерения автора. Тем не менее, поскольку нас интересует не какая-либо отдельная ошибка, а скорее сбор статистики о частотах типов ошибок, такие автоматические средства проверки подходят для нашей цели. Тем не менее, для определенных классов ошибок мы обнаружили, что средство проверки орфографии и грамматики MSWord особенно неадекватно, поэтому мы сами подготовили сценарии для их фиксации. В частности, мы обнаружили, что средство проверки орфографии MSWord было очень слабым при обработке нестандартных слов с грамматическими суффиксами (-ism, -ist, -ble, -ive, -logy, -tion и т. Д.).

Для категорий 3 и 4 мы пропустить текст через теггер Brill [17]. Для категории 4 мы сопоставляем результаты проверки орфографии MSWord (и наши собственные процедуры для слов с идентифицируемыми грамматическими суффиксами) с результатами теггера Brill.

Когда мы прогнали весь наш корпус ошибочных текстов через этот процесс, мы обнаружили, что многие типы ошибок в нашем списке настолько редки, что их не стоит рассматривать. Следовательно, мы сократили наш список типов ошибок до тех 185 типов, которые произошли по крайней мере три раза в большом корпусе сообщений чат-групп, используемых для сбора статистики ошибок (в дополнение к 250 редким биграммам частей речи).

5. Экспериментальная установка

Мы используем International Corpus of Learner English [18], который был собран для точной цели изучения английского письма тех, для кого английский язык не является родным, из разных стран. Все авторы, включенные в корпус, являются студентами университетов (в основном на третьем или четвертом курсе), изучающими английский как второй язык. Все они примерно одного возраста (около двадцати лет) и имеют одинаковый уровень владения английским языком. Мы рассматриваем субкорпорации, внесенные из России, Чехии, Болгарии, Франции и Испании. Чешский субкорпус, состоящий из эссе 258 авторов, является наименьшим из них, поэтому мы берем ровно 258 авторов из каждого субкорпуса (случайным образом отбрасывая излишки). Каждый из текстов в сборнике имеет длину 579 – 846 слов.

Каждый документ в корпусе представлен в виде числового вектора длиной 1035, где каждая запись вектора представляет частоту (относительно длины документа) данной функции в документе. Возможности:

Мы используем мультиклассовые линейные машины опорных векторов (SVM) [19], чтобы изучать модели для различения векторов, принадлежащих каждому из пять классов. Эффективность линейных SVM для категоризации текста уже хорошо подтверждена [20].

Чтобы проверить эффективность моделей, изученных SVM для правильной категоризации невидимых документов, мы провели десять экспериментов с перекрестной проверкой: корпус был случайным образом разделен на десять наборов (приблизительно) равного размера, девять из которых использовались для обучения и десятая часть была использована для тестирования обученной модели. Это повторялось десять раз, и каждый набор проходил для тестирования ровно один раз.

6. Результаты

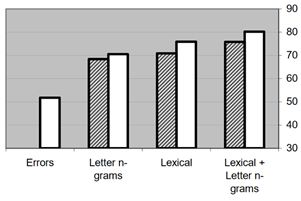

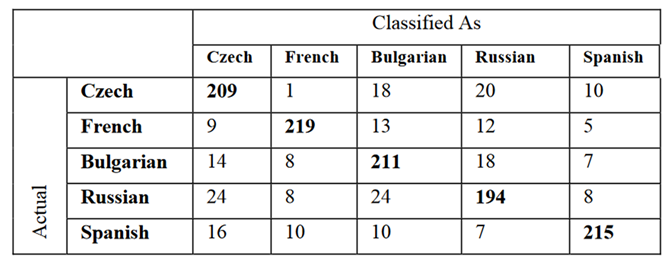

На рисунке 1 мы показываем результаты десятикратной перекрестной проверки точности для различных комбинаций классов пространственных объектов. Как видно, когда все типы функций используются в тандеме, мы получаем точность 80,2%. Матрица неточностей для эксперимента со всеми функциями показана в таблице 1. Следует отметить, что документ считается правильно классифицированным, только если он отнесен к своему правильному классу и никакому другому классу. Таким образом, поскольку у нас есть пять возможных классов примерно одинакового размера, точность 20% является разумной базой для этого эксперимента.

Рис. 1 Точность (ось Y) при десятикратной перекрестной проверке с использованием различных наборов функций (ось x) без (диагональных линий) и с (белыми) ошибками, а также классификация с помощью мультиклассовой линейной SVM. Обратите внимание, что

ошибкиотносятся ко всем типам ошибок, включая редкие биграммы POS

Успех системы зависит от взаимодействия сотен функций. Тем не менее поучительно рассмотреть некоторые особенности, которые оказались особенно полезными в изученных моделях. В таблице 2 показаны различные функции, а также количество документов в каждой категории, в которой появляется эта функция. Мы обнаруживаем, что ряд отличительных паттернов можно было использовать для идентификации носителей определенных языков. Например:

7. Выводы

Мы реализовали полностью автоматизированный метод определения родного языка анонимного автора. В экспериментах с корпусом, включающим авторов из пяти разных стран, наш метод достиг точности более 80% при классификации невидимых документов.

Авторы этих документов, как правило, достаточно хорошо владели английским языком (и, возможно, даже использовали автоматизированные средства проверки правописания), что особенно усложняло задачу. Возможно, однако, что мы смогли несправедливо воспользоваться различиями в общей квалификации между различными субкорпоративными структурами. Например, болгарские авторы в среднем были значительно менее склонны к ошибкам, чем испанские авторы. Один из способов гарантировать устойчивость к таким артефактам доступных данных – это провести аналогичные эксперименты, в которых частота ошибок нормализуется не по длине документа, а по общей частоте ошибок.

Применимость этих методов зависит от ряда факторов. Достаточно ли точен метод для работы с десятками, если не сотнями различных кандидатов на родные языки? Насколько короткими могут быть документы и при этом позволять точную категоризацию? Каждый из этих вопросов требует дальнейшего изучения.