Реферат по теме выпускной работы

- Введение

- 1. Актуальность темы

- 2. Цель и задачи исследования

- 3. Предполагаемая научная новизна

- 4. Обзор исследований и разработок по теме

- 4.1 Глобальный уровень

- 4.2 Национальный уровень

- 4.3 Локальный уровень

- 5. Методы автоматического извлечения отношений.

- 6. Обзор систем анализа тональности текстовых документов.

- 7. Направления дальнейших исследований.

- Заключение

- Список источников

Введение

В сети Интернет содержится огромное количество разнообразных текстов, авторами которых являются обычные пользователи. Это могут бать статьи в блогах, отзывы на продукты, сообщения в социальных сетях и т.п. В этом контенте содержится большое количество ценной информации.

С одной стороны, глобальная сеть вместе с набором поисковых систем (таких как Google) сильно упрощает задачу поиска интересующей информации о продукте или услуге. С другой стороны, Horrigan сообщает [19], что 58% интернет–пользователей считают онлайн–поиск сложным и утомительным занятием. Дело в том, что объемы информации в интернете на сегодняшний день так велики, что релевантные данные попросту теряются в море информационного шума.

Таким образом, возникает необходимость в создании инструмента, который поможет потребителям в принятии правильных решений относительно приобретения тех или иных товаров или услуг. Проще говоря, нужна система, которая будет анализировать мнения членов интернет–сообщества касательно различных предметов обсуждения.

Исследования в этой области проводятся в настоящее время, и на данный момент не существует оптимального решения проблемы автоматического анализа мнений.

1. Актуальность темы

В последние годы происходит бурный рост размеров Интернета, в том числе русскоязычного сегмента. Вместе с увеличением числа пользователей сети Интернет, возрастает и количество генерируемого ими контента. Люди оставляют сообщения на форумах, пишут посты в блогах, комментируют товары на страницах интернет–магазинов и пишут в социальных сетях. Согласно исследованиям Всероссийского центра изучения общественного мнения, количество рускоязыного населения, регулярно (не реже раза в месяц) пользующихся интернетом выросло с 38% в 2010 г. до 55% в 2012 г. Число зарегистрированных в социальных сетях за эти 2 года (с 2010 по 2012 гг.) также значительно возросло — с 53% до 82% [1].

Весь этот контент несет в себе огромное количество информации, которую можно и даже нужно использовать. Существует отдельное направление искусственного интеллекта и математической лингвистики — обработка естественного языка, или компьютерная лингвистика. Оно позволяет извлекать разнообразную информацию, находящуюся в форме текста на естественном языке. Одно из перспективных направлений компьютерной лингвистики — анализ тональности текста.

Анализ тональности текста позволяет извлекать из текста эмоционально окрашенную лексику и эмоциональное отношение авторов по отношению к объектам, о которых идет речь в тексте. Большинство современных систем используют бинарную оценку — «положительный сентимент» или «отрицательный сентимент», однако некоторые системы позволяют выделять силу тональности.

2. Цель и задачи исследования

Цель работы состоит в разработке и исследовании алгоритма анализа эмоционального содержания естественно языковых сообщений блогов и форумов.

Для достижения поставленной цели необходимо решить следующие задачи:

- рассмотреть существующие методы анализа тональности текста;

- проанализировать существующие алгоритмы анализа тональности текста;

- определить требования к разработке алгоритмического обеспечения интеллектуального модуля анализа эмоционального содержания;

- разработать алгоритм анализа эмоционального содержания;

- разработать алгоритм интеллектуального модуля анализа эмоционального содержания естественно языковых сообщений блогов и форумов.

3. Предполагаемая научная новизна

Анализ тональности текста является одним из перспективных направлений компьютерной лингвистики. Это направление искусственного интеллекта позволяет извлекать разнообразную информацию, находящуюся в формеекста на естественном языке.

- Маркетинговые исследования. Проводятся для разнообразных целей, включая изучение потребительских предпочтений, измерение степени удовлетворения потребностей потребителей, определение эффективности распространения продуктов или услуг.

- Финансовые рынки. В работе [19] говорится, что о каждом акционерном обществе существуют многочисленные публикации новостей, статьи, блоги и сообщения в

Твиттере. Система анализа тональности может использовать эти источники для нахождения статей, в которых обсуждаются такие общества, и извлекать отзывы, что позволит создать

автоматическую торговую систему. Одной из таких систем является

The Stock Sonar

. Система показывает графически ежедневные позитивные и негативные настроения о каждой акции рядом с графиком цены акции. По настроениям предсказывается дальнейший рост или падение цены акции. - Рекомендательные системы. Анализируются отзывы и обзоры различных продуктов с целью помощи покупателям при выборе товара. Например, система не будет рекомендовать продукт, если он получил много отрицательных отзывов.

- Анализ новостных сообщений. Анализируются новостные ресурсы на предмет тональности сообщений относительно различных персон и событий.

- Политологические исследования. Собираются данные о политических взглядах населения. Это может иметь существенное значение для кандидатов, выступающих от разных партий. Такой подход применяется организаторами предвыборной кампании для выявления того, что думают избиратели в отношении различных проблем, и как они связывают эти проблемы со словами и действиями кандидатов [19].

- Социологические исследования. Анализируются данные из социальных сетей, например для выявления религиозных взглядов или различия между мужчинами и женщинами в употреблении эмоционально–окрашенных слов в сообщениях.

- Поддержка поисковых систем (search engines) и систем извлечения информации (information extracting systems). В таких системах анализ тональности может служить для отделения фактов от мнений.

- Анализ обратной связи от пользователей (consumer feedback analysis). При диалоге с пользователем система распознает его эмоции, и при помощиобратной связи может реагировать в соответствии с ними (например, в случае отрицательных эмоций переключать связь на оператора–человека).

- Анализ экстремистских ресурсов. Анализируются Интернет–ресурсы экстремистского содержания на предмет подозрительной активности.

- Психологические исследования. Определение депрессии у пользователей социальных сетей.

4. Обзор исследований и разработок по теме

4.1 Мировой уровень

Автоматическая классификация текстов имеет длительную историю, уходящую в начало 1960–х гг. Вплоть до конца 1980–х гг. наиболее популярным подходом к классификации документов была инженерия знаний (knowledge engineering), заключающаяся в ручном определении правил, содержащих знания экспертов о том, как определить, к какой категории относится документ. В 1990–х гг. с бурным развитием производства и доступности онлайн документов интерес к автоматической классификации усилился. Новая тенденция, основанная на машинном обучении, вытеснила предыдущий подход. Эта тенденция заключалась в том, что на основе индуктивного процесса автоматически создается классификатор путем обучения с помощью набора предварительно классифицированных документов, характеризующихся одной или более категориями. Преимуществом является высокая эффективность и значительное сохранение опыта экспертов [20].

Проблема автоматического распознавания мнений в тексте оказалась предметом активных исследований за рубежом сравнительно недавно — в 2000–х гг. В России таких работ до последнего времени было крайне мало; только в 2012 году оценка тональности текста была выбрана одной из главных тем конференции по компьютерной лингвистике Диалог–2012.

Исследование эмоционального содержания текста и определение его тональности проводились Котельниковым Е. В. [3], Худяковым М.В., Давыдовым С., Васильевом В.Г [6], Клековкиным М.В. [7]. В них рассматриваются методы автоматической обработки текстов и машиного обучения, использованные авторами для решения задачи анализа мнений. Обсуждаются вопросы выбора оптимального варианта векторной модели представления текстов и наиболее подходящего метода машинного обучения, рассматриваются варианты построения векторной модели на основе подхода TF.

В работах зарубежных авторов Esuli A., Sebastiani F. [4], Hu M., Liu B. [5], Chisholm E., Kolda T. G. [9], Debole F., Sebastiani F. [10]. Представлены методы автоматической классификации текстов по тональности, основанный на словаре эмоциональной лексики. Приводятся описания процессов создания словаря: выделение оценочных слов, назначение им весов, определение влияния слов–модификаторов и слов, выражающих отрицание. Результаты сравниваются с результатами других методов.

4.2 Национальный уровень

Среди работ Украинских ученых, направленных в эту сферу, важный вклад был произведен Святогором Л. А. и Гладуном В. П. В их работе «Сематтический анализ текстов естественного языка: цели и средства» предлагается расширенное толкование понятия «текст естественного языка» [23] и предлагается схема полного освоения его семантического ресурса за счёт «компьютерного понимания» и диалога. Указываются средства достижения указанной цели в процессе семантической обработки текстов — использование трёхуровневой онтологии для извлечения из текста онтологического смысла, а также ввод обратной связи для дополнительного уточнения в диалоге содержания дискурса [24].

4.3 Локальный уровень

В Донецком Национальном Техническом Университете Разработкой Семантические модели природно-речевых методов в системах тестирования занимался Кушнарев А. В. [24]. Разработкой и исследованиями алгоритмов для повышения эффективности интеллектуального анализа web–контента занималась Арбузова О.В. [25]. Также в своей работе исследовали формализацию словообразовательного синтеза на основе семантических свойств формантов Егошина А.А., Вороной С.М [26].

5. Методы автоматического извлечения отношений.

При решении задачи извлечения отношений наиболее эффективными методами являются: обучение без учителя и статистические методы. Этим методам не нужны размеченные тренировочные данные, отсутствующие в свободном доступе, по сравнению к примеру, с лингвистическими корпусами, созданными для решения классических задач компьютерной лингвистики: определения частей речи, лемматизации и т.д.

Обучение без учителя — один из способов машинного обучения, при решении которых испытуемая система спонтанно обучается выполнять поставленную задачу, без вмешательства со стороны экспериментатора. Как правило, это пригодно только для задач, в которых известны описания множества объектов (обучающей выборки), и требуется обнаружить внутренние взаимосвязи, зависимости, закономерности, существующие между объектами. Обучению без учителя можно сопоставить с методом обучения с учителем, для каждого объекта из выборки уже задан правильный ответ, необходимо найти зависимость между ответами и объектами.

Проанализируем один алгоритм методов обучения без учителя и применим к задаче извлечения аспектов. В основе методов распространения лежит следующая идея: с помощью небольшого множества вручную определенных примеров определенного класса итеративно извлекать подобные единицы текста, постепенно накапливая множество.

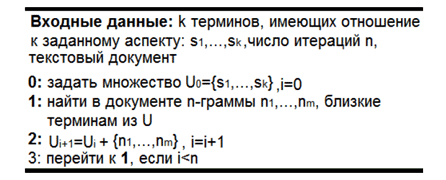

В применении к задаче извлечения отношений, алгоритм метода распространения может выглядеть так, рисунок 1.

Рисунок 1 – Алгоритм распространения для задачи определения отношений

В исследовании кандидатами в термины могут буть только n–граммы размером от 1 до 3 слов, содержащие только существительные, прилагательные, глаголы и наречия. Близость n–граммы и терминов из множества U_i определена с помощью RlogF метрики :

где Freg(ng,U) — частота совместной встречаемости n–граммы ng, и терминов из U в рамках фрагментов текста, состоящего из фиксированного числа слов.

Задачу извлечения отношений можно рассматривать, как задачу извлечения терминов, часто употребляемых авторами мнений [13,20].

В [13] исследователи предполагают, что терминами, описывающими отношения, могут быть одиночные существительные и словосочетания содержащие существительное, часто встречающиеся во мнениях об объектах одного и того же типа. Из всех n–грамм слов, удовлетворяющих этому требованию, выделяются те, с частотой в корпусе более одного процента.

Выделенные n–граммы, состоящие из двух и более слов, проходят проверку на компактность. Если n–грамма компактна как минимум в двух предложениях, то она попадает в список аспектов.

Компактность определяется следующим образом:

- пусть f — n–грамма из n слов, s — предложение, содержащее все слова из f (возможно расположенные не подряд);

- если расстояние между любыми двумя словами, смежными в f, в предложении s составляет не более чем три слова, то f компактна в данном конкретном предложении.

Термины, состоящие из одного слова, также проходят статистический тест на чистоту. Отыскиваются все предложения, содержащие термин. Среди найденных предложений подсчитываются предложения , не содержащие прошедший тест на компактность n–граммы, в которые входит этот термин. Если число таких предложений выше некоторого экспериментально определенного порога, то термин попадает в список отношений.

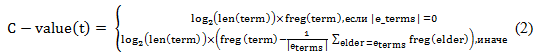

Похожий статистический метод выявления терминов — аспектов, состоящих из двух и более слов, используется в работе [20] и имеет название C–value [19]. Для всех n–грамм, содержащих в себе только определенные части речи, входящие в некоторые множества документов, вычисляется их зависимость, определенная формулой (2).

Где term — n–грамма, e–terms — множество, состоящее из всех n–грамм старшего порядка, содержащий term, |e–terms| мощность множества elder — элемент этого множества. Длина термина в символах — len(term).

Рассмотрим пример, иллюстрирующий работу C–value метода. Пусть в корпусе мнений о сотовых телефонах биграмма retina display

встречается 8 раз, содержащие ее триграммы great retina display

и

retina display worse

встречаются 3 и 2 раза соответственно. Тогда согласно формуле (2):

C–value(retina display)=log(13)*(8-1/2(2+3))≈20

C–value(great retina display)= log(18)*3≈13 (3)

C–value(retina display worse)= log(18)*2≈8

Если экспериментально установленный порог C–value для данного корпуса равен 15, то только n–грамма retina display

попадет во множество терминов–аспектов.

Для решения задачи определения полярности предложений и коротких сообщений эффективны как алгоритмы обучения с учителем, так и методы, основанные на словарях.

Недостатком метода обучения с учителем является составление тренировочного корпуса с примерами из предметной области, в которой будет использоваться классификатор. Однако схожей проблемой обладают и словарные методы: веса терминов словаря, составленного для одной предметной области, могут оказаться малоэффективными для другой.

6. Обзор систем анализа тональности текстовых документов

SentiStrength

– система, разработанная M. Thelwall, K. Buckley, G. Paltoglou и D. Cai. Начальное назначение было, для анализа коротких неструктурированных неформальных текстов

на английском языке. Система может быть сконфигурирована для работы с текстом, также и для других языков, в том числе и для текста на русском языке.

Результат выдается в виде двух оценок — оценка позитивной составляющей текста (по шкале от +1 до +5) и оценка негативной составляющей (по шкале от -1 до -5). Также, возможно предоставления оценок в другом виде: бинарная оценка (позитивный/негативный текст); тернарная оценка (позитивный/негативный/нейтральный); оценка по единой шкале от -4 до +4.

Алгоритм основан на поиске максимального значения тональности в тексте для каждой шкалы (т.е. поиск слова с максимальной негативной оценкой и слова с максимальной позитивной оценкой).

При работе алгоритма учитывается простейшее взаимодействие слов (например, слова-усилители усиливают значение тональности для слова, на которое они действуют — очень злой

будет иметь более

негативную оценку, нежели просто злой

) и идиоматические выражения.

Недостатки системы: система может быть сконфигурирована для русского языка, реализованные в ней алгоритм не учитывают его специфику, в том числе русскую морфологию, что приводит к ряду проблем. Кроме того, система считает лишь общую тональность текста, не выделяя субъекты и объекты тональности.

Компонент анализа тональности текста в составе систем Аналитический курьер

и X–files

– разработан компанией Ай-Теко

. Компонент определения тональности текста реализует метод, основанный

на словарях и правилах.

Данная система выдает пользователю массив размеченных предложений. В предложениях размечаются объекты тональности (при наличии таковых) и цепочка слов, несущая в себе тональность по отношению к ним.

Кроме того, на основании найденных цепочек слов подсчитывается общая тональность для каждого предложения. Для подсчета общей тональности используется ряд специальных правил. Например (для предложения

Доктор Смит вылечил больного гриппом

), есть правило, которое говорит, что сочетание позитивного глагола вылечить

с негативной цепочкой (в данном случай больной гриппом

) приписывает позитив

подлежащему глагола (в нашем примере – доктору Смиту

). Тональность оценивается по тернарной шкале (позитивный/негативный/нейтральный).

Система работает в несколько этапов: предварительная обработка текста, выделение и классификация найденных слов; объединение найденных слов в связанные друг с другом цепочки; выделение объектов тональности. Недостатки системы: отсутствие количественной оценки текста. Пример определения тональности текста на рисунке 2.

Рисунок 2 – Пример определения тональности текста

(анимация: 5 кадров, 10 циклов повторения, 238 Кб)

«Ваал» — система, разработанная Шалак Владимиром. Данная система предназначена для оценки «неосознаваемого эмоционального воздействия фонетической структуры текста и отдельных слов на

подсознание человека». Работа системы основана на превращении текста в частотный словарь и отнесении некоторых слов к определенным психолингвистическим категориям. Результат анализа выдается

пользователю в виде набора оценок по ряду критериев, относящихся к данному тексту/слову (гладкий-шероховатый

, могучий-хилый

) и т.д. Недостатки системы: система не производит анализ семантики текста,

что ведет к сильной ограниченности применимости продукта. Кроме того, использование данного продукта людьми, не являющимися специалистами в области психолингвистики, не представляется возможным.

Компонент анализа тональности в составе системы RCO Fact Extractor — система, разработанная компанией RCO. Для анализа тональности текста система использует подход, основанный на правилах. Данная система учитывает синтаксическую структуру текста и взаимодействие различных типов слов.

Работа компонента происходит в пять этапов:

- распознавание всех упоминаний об объекте во всех формах, включая полные, краткие и другие формы упоминаний;

- отсев и полный синтаксический разбор конструкций, в которых отражаются все события и признаки, связанные с целевым объектом;

- выделение и классификация тех позиций, в которых явно выражается тональность, и тех пропозиций, которые описывают эмоционально-коннотативные ситуации;

- для каждой пропозиции принятие решения о тональности

позитив-негатив

с учетом тех мест, которые занимают в её составе эмоционально–коннотативные, тональные и нейтральные слова, средства выражения отрицания; - оценка общей тональности текста на основе тональностей всех входящих в него пропозиций.

Для своей работы компонент использует модули синтаксического анализа текста и отождествления наименований, разработанные также в компании RCO. Недостатки системы: отсутствие количественной оценки текста.

7. Направления дальнейших исследований

Разработка алгоритмического обеспечения интеллектуального модуля анализа эмоционального содержания естественно языковых сообщений блогов и форумов.

Заключение

На основе проведенного анализ можно сделать вывод, что все методы анализа можно отнести к классу обучение с учителем. Результаты их работы отличаются от используемой метрики эффективности.

Работа этих методов обычно достигает более 70% точности. Исследователи часто комбинируют подходы для достижения наилучших результатов. Например, научная работа Васильева В.Г., Давыдова С. и Худяковой М.В. [6] использует лингвистический подход, дополненный методами машинного обучения для коррекции отдельных правил классификации путем обучения.

Более популярным является лингвистический подход, так как алгоритмы, основанные на правилах, дают более точные результаты, в связи с тем, что работа этих методов тесно связана с семантикой слов, в отличие от методов машинного обучения, оперирующих со статистикой и теорией вероятности.

Список источников

- Turney P. Thumbs up or thumbs down? Semantic orientation applied to unsupervised classification of reviews // Proceedings of ACL–02, 40th Annual Meeting of the Association for Computational Linguistics, Association for Computational Linguistics, 2002, pp. 417–424.

- Васильев В. Г., Худякова М. В., Давыдов С. Классификация отзывов пользователей с использованием фрагментных правил // Компьютерная лингвистика и интеллектуальные технологии: по материалам ежегодной международной конференции «Диалог». Вып. 11 (18), М.: Изд-во РГГУ, 2012, С. 66–76.

- Котельников Е. В. Автоматический анализ тональности текстов на основе методов машинного обучения // Компьютерная лингвистика и интеллектуальные технологии: по материалам ежегодной международной конференции «Диалог». Вып. 11 (18), М.: Изд–во РГГУ, 2012, С. 27–36.

- Esuli A., Sebastiani F. Determining the Semantic Orientation of Terms through Gloss Classification // Conference of Information and Knowledge Management (Bremen). ACM, New York, NY, 2005, pp. 617–624.

- Hu M., Liu B. Mining and Summarizing Customer Reviews // KDD, Seattle, 2004, pp. 168–177.

- Худякова М.В., Давыдов С., Васильев В.Г. Классификация отзывов пользователей с использованием фрагментных правил. РОМИП 2011., С. 87–102.

- Клековкина М.В. Метод классификации текстов по тональности, основанный на словаре эмоциональной лексики// Компьютерная лингвистика и интеллектуальные технологии: по материалам ежегодной международной конференции «Диалог». Вып. 10 (18), М.: Изд–во РГГУ, 2011, С. 51–67.

- Вишневская Н.И. Программа анализа тональности текстов на основе методов машинного обучения // Дипломная работа, М. 2013, 9–17.

- Chisholm E., Kolda T. G. New term weighting formulas for the vector space method in information retrieval. Technical Report Number ORNL-TM-13756,Oak Ridge National Laboratory, Oak Ridge, TN, March 1999, С. 105–120.

- Debole F., Sebastiani F. Supervised term weighting for automated text categorization.Proceedings of the 2003 ACM symposium on Applied computing SAC 03,2003, Vol. 138(Ml), pp. 784–788.

- Joachims T. A probabilistic analysis of the Rocchio algorithm with TFIDF for text categorization. Proceedings of 14th International Conference on Machine Learning, Nashville, TN, 1997, pp. 143–151.

- Joachims T. Text categorization with support vector machines: learning with many relevant features. Proceedings of 10th European Conference on Machine Learning, Chemnitz, Germany, 1998, pp. 137–142.

- Lan M. (2007) A New Term Weighting Method for Text Categorization. PhD Theses, pp. 35–113.

- Lan M., Tan C. L., Su J., Lu Y. (2009), Supervised and Traditional Term Weighting Methods for Automatic Text Categorization, IEEE Transactions on Pattern Analysis and Machine Intelligence, Vol. 31, no. 4, pp. 721–735.

- Lewis D. D. Naive (Bayes) at forty: The independence assumption in information retrieval. Proceedings of 10th European Conference on Machine Learning, Chemnitz, Germany, 1998, pp. 4–15.

- LIBSVM — A Library for Support Vector Machines, available at: http://www.csie.ntu.edu.tw/~cjlin/libsvm/.

- Masand B., Linoff G., Waltz D. Classifying news stories using memory-based reasoning. Proceedings of SIGIR-92, 15th ACM International Conference on Research and Development in Information Retrieval, Copenhagen, Denmark, 1992, pp. 59–65.

- Mihalcea R., Tarau P. Textrank: Bringing order into texts. Proceedings of the Conference on Empirical Methods in Natural Language Processing, Barcelona, Spain, 2004, pp. 404–411.

- Pang B., Lee L. (2008), Opinion Mining and Sentiment Analysis, Foundations and Trends® in Information Retrieval, no. 2, pp. 1–135.

- Pang B., Lee L., Vaithyanathan S. Thumbs up? Sentiment classification using machine learning techniques. Proceedings of the Conference on Empirical Methods in Natural Language Processing (EMNLP), 2002, pp. 79–86.

- Salton G., Buckley C. (1988), Term–weighting approaches in automatic text retrieval, Information Processing & Management, Vol. 24, no. 5, pp. 513–523.

- Sebastiani F. (2002), Machine learning in automated text categorization ACM Computing Surveys, Vol. 34, no. 1, pp. 1–47.

- Святогор Л. Семантический анализ текстов естесственного языка: цели и средства / Л. Святогор, В. Гладун // XV th International Conference “Knowledge-Dialogue-Solution” KDS-2 2009, Киев, Украина, Октябрь, 2009.

- Кушнарев А.В. Семантические модели природно-речевых методов в системах тестирования// реферат выпускной работы магистра Факультет вычислительной техники и информатики ДонНТУ. 2012.

- Арбузова О. В. Разработка и исследование алгоритмов для повышения эффективности интеллектуального анализа web-контента// реферат выпускной работы магистра Факультет вычислительной техники и информатики ДонНТУ. 2013.

- Вороной С.М., Егошина А.А. Формализация словообразовательного синтеза на основе семантических свойств формантов [Электронный ресурс]. – Режим доступа: Data mining techniques.htm

При написании данного реферата магистерская работа еще не завершена. Окончательное завершение: декабрь 2014 года. Полный текст работы и материалы по теме могут быть получены у автора или его руководителя после указанной даты.