Реферат по теме выпускной работы

Содержание

- Введение

- 1. Цель и задачи исследования

- 2. Предполагаемая научная новизна

- 3. Практическая значимость

- 4. Проблема обучающих выборок с множеством коэффициентов

- 5. Обзор исследований и разработок

- 5.1 Виды обработки данных

- 5.2 Способы сжатия данных

- 5.3 Алгоритм STOLP

- 5.4 Алгоритм LVQ

- Выводы

- Список источников

Введение

Еще до недавно, задачи распознавания рассматривались человеком лишь с позиции качественных характеристик, которые основывались на изучении рецепторов, таких как органы зрения, слуха, осязания. Математическую оценку принятия решения не проводили. Но, недавно появившаяся, кибернетика позволила проводить метод математического анализа, что позволило открыть новые возможности в исследовании и проектировании автоматических систем распознавания. Это позволяет заменить человека специализированным автоматом. Такая замена позволяет значительно расширить возможности систем, которые выполняют сложные информационно-логические задачи. Ведь качество работ, выполняемых человеком, очень сильно зависит от человеческого фактора. В автоматизированных системах человеческий фактор отсутствует, что позволяет предотвратить многие ошибки, которые бы могли возникнуть в неавтоматизированных системах.

На протяжении достаточно продолжительного времени, проблема распознавания продолжает привлекать внимание специалистов в разных научных областях. Появляются все новые и новые алгоритмы построения обучающих выборок в системах распознавания. Но ведь не все алгоритмы дают одинаково хороший результат. Информация об изменении распознаваемых объектов поступает в системы распознавания в большинстве случаев в виде новых объектов обучающей выборки, количество которых может достигать десятков тысяч, поэтому для адаптивных систем одной из ключевых проблем является проблема предобработки исходных выборок данных [1]. Именно поэтому оптимизация этих алгоритмов является одним из приоритетных направлений анализа данных в адаптивных системах распознавания.

1. Цель и задачи исследования

Объектом исследования является задача оптимизации выборок с множеством весовых коэффициентов.

Предметом исследования – методы построения и оптимизации взвешенных обучающих выборок.

Целью выпускной работы магистра является разработка методов построения и оптимизации взвешенных обучающих выборок с множеством весовых коэффициентов в адаптивных системах распознавания.

В процессе работы необходимо решить следующие задачи:

2. Предполагаемая научная новизна

Научной новизной данной работы является разработка метода построения и оптимизации обучающих выборок в адаптивных системах распознавания с учетом множества весовых коэффициентов. Принцип построения взвешенных обучающих выборок состоит в усреднении локального подмножества данных, то можно предположить, что на основе взвешенных выборок с множеством весовых коэффициентов может быть построен эффективный алгоритм объединения данных в кластера, которой бы показывал лучшие результаты распознавания и более быстрое выполнение.

3. Практическая значимость

Практическая значимость данной работы состоит в разработке метода построения и оптимизации взвешенных обучающих выборок. Если множество весовых коэффициентов в этих выборках будет очень велико, то могут потребоваться большие вычислительные затраты и большое количество времени для выполнения алгоритма. К тому же, не всегда будет получено наилучшее решение. Поэтому оптимизация выборок с помощью объедения данных, позволила бы повысить качество исходного множества данных и, как результат, эффективность работы всей системы в целом.

4. Проблема обучающих выборок с множеством коэффициентов

В памяти машины необходимо хранить сведения об всех реализациях обучающей выборки [2]. Но если сократить выборки с помощью эталонов и хранить только часть реализации выборки, то это существенно упростит распознавание. Например, оставить в качестве эталона только те точки, при которых расстояние от любой точки обучающей выборки до ближайшего эталона, меньше расстояния до ближайшего эталона другого класса. Но в данном случае существует риск столкнуться с такой ситуацией, при которой решение задачи возможно только в случае перебора всех вариантов. Если количество объектов в выборке составляет k, то число проверок в обучающей выборке равно mi , а число всех возможных вариантов для одного эталона для каждого k равно сумма всех k от начального до последнего объекта выборки. Очевидно, что задача в таком случае носит комбинаторный характер и является трудно решаемой. Для упрощения данной задачи существует ряд алгоритмов, которые будут рассмотрены ниже.

5. Обзор исследований и разработок

5.1 Виды обработки данных

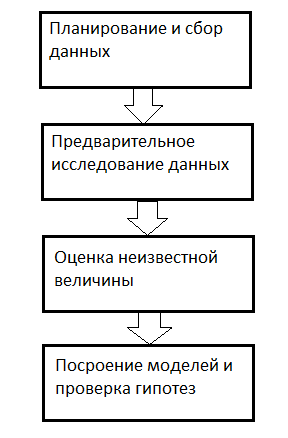

Предобработка данных в системах распознавания является итеративным процессом, который включает очистку данных, сжатие данных и объединение данных. Очистка данных заключается в удалении шума, пропусков в данных и данных низкого качества.

Сжатие данных включает нахождение минимальные признаковые пространства и репрезентативные множества данных на основе методов редукции и трансформации. Объединение данных позволяет уменьшить объем данных с сохранением исходной информации с помощью эвристических алгоритмов.

5.2 Способы сжатия данных

Актуальной задачей является сжатие данных, ведь это позволяет уменьшить объем данных с сохранением первоначальной информации. Существует несколько методов, которые позволяют это сделать.

Первый метод заключается в отборе некоторого множества объектов исходной обучающей выборки, каждый объект которой должен отвечать требованиям.

Второй метод отличается от первого тем, что использует другой способ отбора объектов, при этом используя расстояние и критерий оптимальности полученной выборки. Он заключается в построении множества новых объектов выборки, которые строятся по информации о некотором подмножестве объектов исходной выборки.

Для первого способа используются алгоритмы STOLP, FRiS-STOLP, NNDE (Nearest Neighbor Density Estimate) и MDCA (Multiscale Data CondensationAlgorithm). К алгоритмам, реализующим второй способ относятся алгоритмы LVQ (learning vector quantization), алгоритм четко горазбиения пространства признаков, алгоритм GridDC, сетевой метод построения взвешенных выборок w-объектов.

5.3 Алгоритм STOLP

Для разбиения всего множества объектов на эталонные, шумовые (выбросы) и неинформативные объекты, используют алгоритм STOLP. Эталонами для данного алгоритма являются подмножество выборки, при котором все объекты классифицируются правильно при использовании обучающей выборки множества эталонов. Сам алгоритм выглядит как набор последовательных действий. Изначально есть обучающая выборка :

где xi – объекты, yi=y*(xi) – классы, которым принадлежат эти объекты. Кроме того, задана метрика p X × X → R, такая, что выполняется гипотеза компактности.

Пример выполнения алгоритма STOLP приведен на изображении 2. В качестве эталона были изначально выбраны точки 1 и 2. Но после пробного распознавания всех точек обучающей выборки список эталонов пополнился точками 3, 4, 5.

В итоге, множество объектов классифицировалось на эталонные, неинформативные и выбросы. Однако, алгоритм STOLP имеет не высокую эффективность. Это объясняется тем, что для каждой новой итерации (при присоединении очередного эталона) необходимо заново классифицировать все объекты, которые могут стать эталонами. Для этого нежно считать на них величину риска.

5.4 Алгоритм LVQ

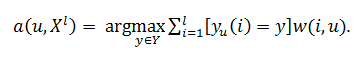

Алгоритм сокращения обучающей выборки имеет схожую идею с задачей кластеризации. Он заключается в разбиении исходной выборки на подмножества и их обработку. Применяется преимущественно для кластеризации выборок большого объема и позволяет выделить кластеры сложной формы.

Сеть LVQ имеет два слоя: конкурирующий и линейный. Конкурирующий слой выполняет кластеризацию векторов, а линейный слой соотносит кластеры с целевыми классами, заданными пользователем. [3]

Как в конкурирующем, так и в линейном слое приходится 1 нейрон на кластер или целевой класс. Таким образом, конкурирующий слой способен поддержать до S1 кластеров; эти кластеры, в свою очередь, могут быть соотнесены с S2 целевыми классами, причем S2 не превышает S1.

Поскольку заранее известно, как кластеры первого слоя соотносятся с целевыми классами второго слоя, то это позволяет заранее задать элементы матрицы весов LW21. Однако чтобы найти правильный кластер для каждого вектора обучающего множества, необходимо выполнить процедуру обучения сети.

6. Анализ построения и оптимизации взвешенных обучающих выборок с множеством весовых коэффициентов

Анализ построения оптимизации взвешенных обучающих выборок с множеством весовых коэффициентов в адаптивных системах распознавания показал следующие особенности реализации этапов построения систем. Первым этапом есть определение признаков объектов. Заключается в том, чтобы определить полный набор признаков, характеризующих объекты или явления, для распознавания которых разрабатывается система. Первоначально необходимо определить все признаки, хотя бы в малейшей мере характеризующие объекты или явления.

Далее необходимо составить априорный алфавит классов. Главным в этой задаче является выбор правильного принципа классификации, удовлетворяющего требованиям, предъявляемым к системе классификации. При решении последующих задач из априорного алфавита классов формируется рабочий алфавит классов системы.

Разработка априорного словаря признаков заключается в разработке априорного словаря признаков, в который войдут только те признаки, относительно которых может быть получена априорная информация, необходимая для описания классов на языке этих признаков. При описании всех классов априорного алфавита классов на языке признаков, включенных в априорный словарь признаков, используется метод обучения, самообучения или непосредственной обработки исходных данных [4]. После того, как все классы априорного алфавита были описаны, необходимо разбить априорное пространство признаков на области, соответствующие классам априорного алфавита классов.

Построение рабочего алфавита признаков и классов представляет собой общую постановку проблемы распознавания. Суть ее заключается в разработке такого алфавита классов и такого словаря признаков, которые в условиях ограничений на построение системы распознавания обеспечивают максимальное значение показателя эффективности системы распознавания, принимающей в зависимости от результатов распознавания неизвестных объектов соответствующие решения [5].

Оценка эффективности работы системы. Состоит в выборе показателей эффективности системы распознавания и оценке их значений. В качестве показателей эффективности системы могут быть выбраны, например, среднее время распознавания, вероятность правильной работы. Эффективность работы системы, как правило, оценивается на основании экспериментальных данных, полученных в ходе исследований. Функционирование систем автоматического распознавания открытого типа, обучаются с точки зрения решения задачи построения решающих правил.

Выводы

В данной работе была рассмотрена задача разработки и анализа алгоритмов построения и оптимизации взвешенных обучающих выборок с множеством весовых коэффициентов в адаптивных системах распознавания. Выяснены проблемы обучающих выборок с множеством коэффициентов. Рассмотрены виды обработки данных и способы их сжатия.

Выполнен анализ существующих методов построения и оптимизации взвешенных обучающих выборок. Наличие весов в выборках w-объектов позволяет сохранять информацию о количестве заменяемых объектов, а так же, позволяет провести характеристику той области, на которой они расположены. По результатам проведенного анализа в качестве объекта исследования выбран алгоритм STOLP. Исходя из этого, разработка нового метода на основе взвешенных обучающих выборках дает большой ряд преимуществ.

Список источников

- Волченко Е.В. Сеточный подход к построению взвешенных обучающих выборок w-объектов в адаптивных системах распознавания // Вісник Національного технічного університету

Харківський політехнічний інститут

. Збірник наукових праць. Тематичний випуск: Інформатика i моделювання. – Харків: НТУХПІ

, 2011. – № 36. – С. 12 - Профессиональная научная библиотека избранных естественно-научных изданий - Научная-библиотека.рф [Электронный ресурс]. – Режим доступа: http://www.sernam.ru/book_zg.php?id=49

- Информационно-аналитический ресурс, который посвящен вопросам ИИ - [Нейронные сети Электронный ресурс]. – Режим доступа:

http://neural-networks.ru/Arhitektura-LVQ-seti-51.html - Волченко Е.В., Кузьменко И.Ю. Анализ методов нахождения выбросов в обучающих выборках // Проблемы информатики и модеоирования. Тезисы одиннадцатой международной научно-технической конференции. Секция

Молоді вчені

. – Х.: НТУХПІ

, 2011. – С. 12 – 13. - Загоруйко Н.Г. Методы распознавания и их применение. – М.: Сов. радио, 1972. – 208 с.

- Матвеев Ю.Н. Основы теории систем и системного анализа: Учебно-методическое пособие. Ч.1 // Тверь: ТГТУ, 2007. – С. 5

- Профессиональный информационно-аналитический ресурс, посвященный машинному обучению, распознаванию образов и интеллектуальному анализу данных - Интеллектуальный анализ данных [Электронный ресурс]. – Режим доступа: http://www.machinelearning.ru/wiki/index.php

- Крисилов В.А., Юдин С.А., Олешко Д.Н. Использование гипотезы -компактности при построении обучающей выборки для прогнозирующих нейросетевых моделей // System Research & Information Technologies. – 2006. – № 3.

- Волченко Е.В. О способе опеределения близости объектов взвешенных обучающих выборок // Весник НТУ

ХПИ

, выпуск №38, 2012